TLDR

- Бета-версия 1 для разработчиков iOS 18.2 представляет визуальный интеллект на моделях iPhone 16.

- Соответствующие требованиям пользователи могут использовать его, нажав и удерживая кнопку управления камерой.

- Вы можете положиться на Google или ChatGPT, чтобы идентифицировать предметы или ориентиры и анализировать свое окружение.

Как заядлый энтузиаст технологий с более чем двадцатилетним опытом работы в этой области, я должен признать, что внедрение Apple Visual Intelligence на моделях iPhone 16 в бета-версии iOS 18.2 для разработчиков меняет правила игры. Имея возможность протестировать Google Lens и аналогичные функции искусственного интеллекта на различных устройствах, я могу с уверенностью сказать, что Apple удалось предложить привлекательную альтернативу.

💰 За гранью мелочей! Top Crypto – место, где монеты становятся настоящим профитом. Время зарабатывать по-крупному!

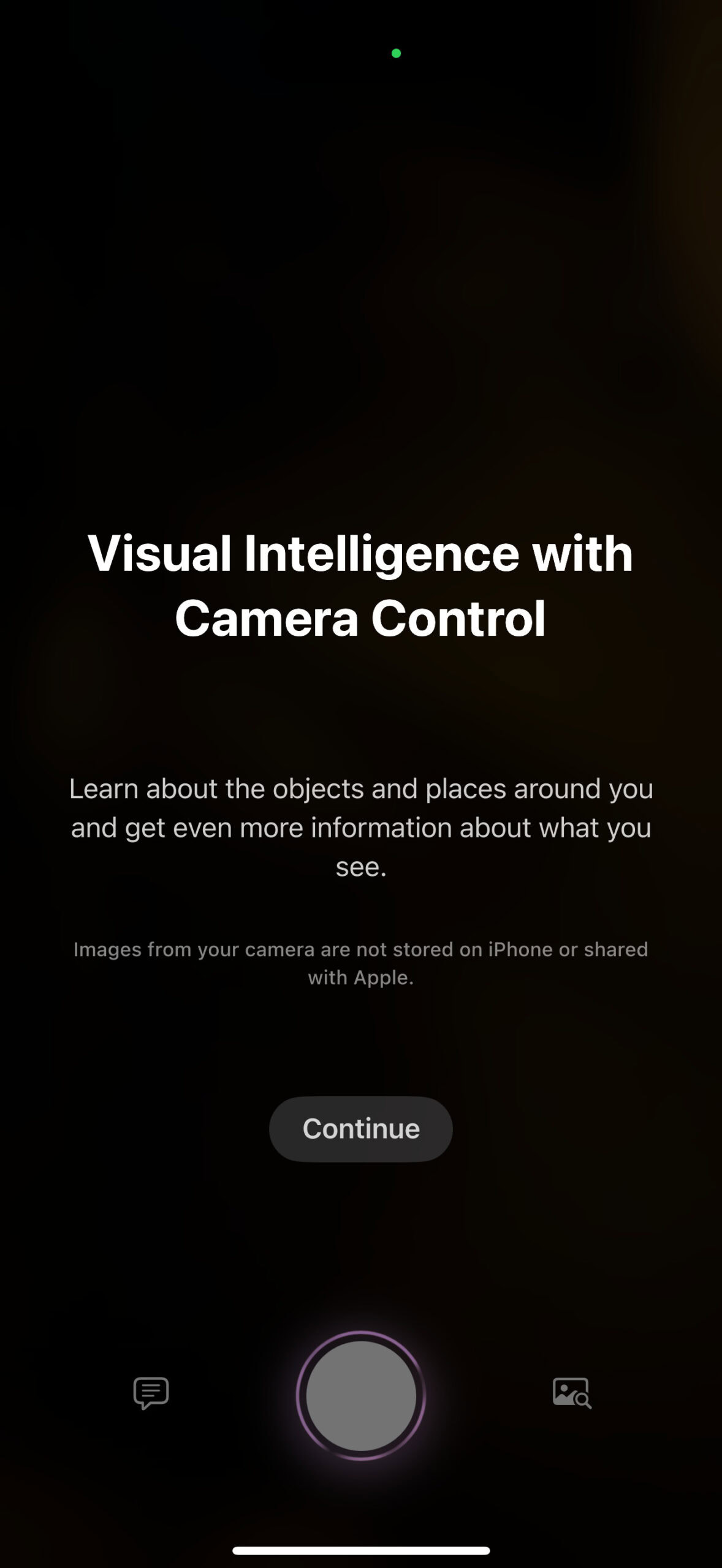

Присоединиться в ТелеграмНачиная с бета-версии iOS 18.2 для разработчиков, Apple предоставляет некоторым тестировщикам вторую группу функций искусственного интеллекта. Эти новые функции Apple Intelligence включают встроенную функциональность ChatGPT, Image Playground, Genmoji и дополнительные улучшения. Особый интерес представляет то, что пользователи iPhone 16, обновившиеся до iOS 18.2, теперь могут использовать Visual Intelligence, нажав кнопку управления камерой.

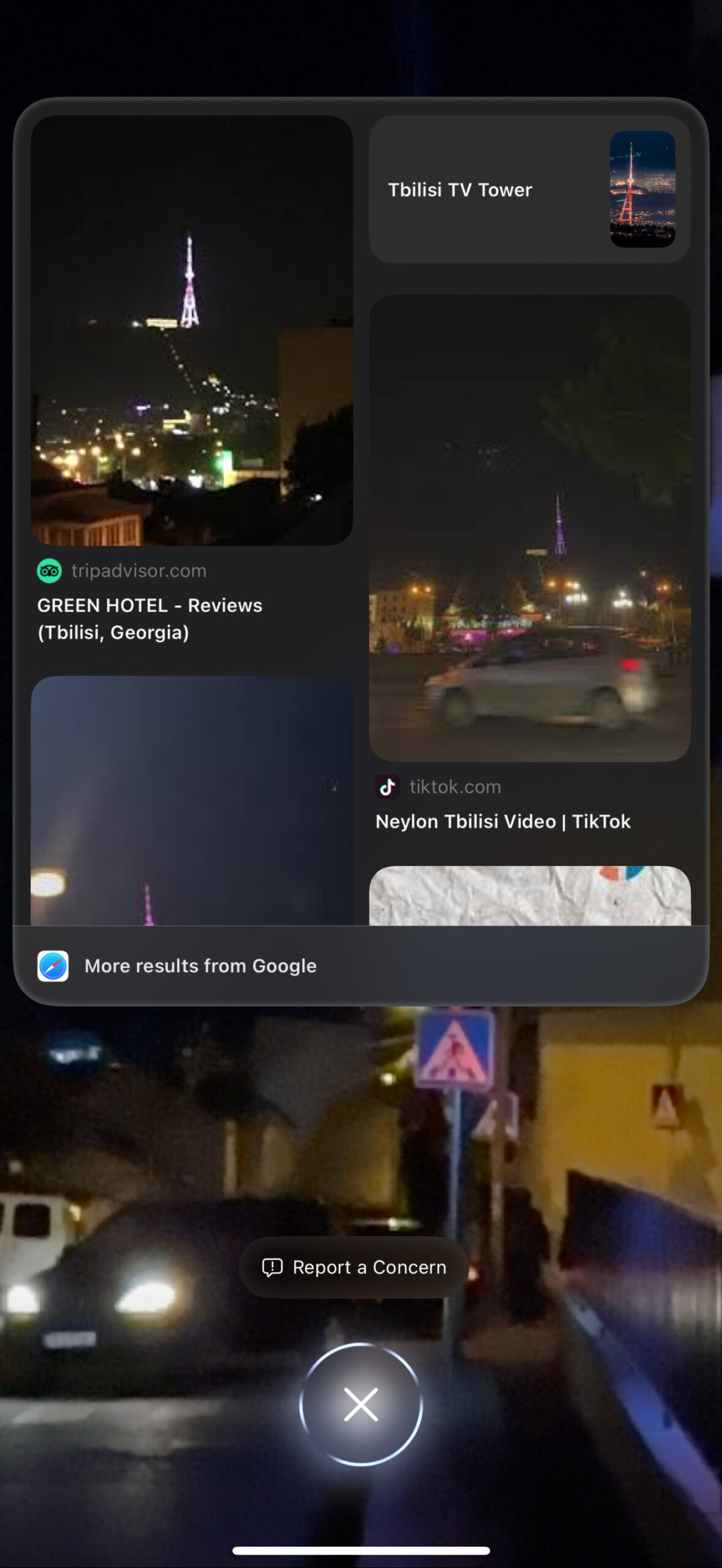

В iOS 18.2 Visual Intelligence работает аналогично Google Lens от Apple. Когда вы нажимаете и удерживаете кнопку управления камерой, появляется пользовательский интерфейс для сканирования окружающей среды. Нажав кнопку спуска затвора, пользователи могут выбрать ChatGPT для интерпретации изображения или использовать обратный поиск изображений Google, чтобы найти похожие изображения в Интернете и получить представление о предмете.

Вот один из способов перефразировать этот разговор:

Тем временем встроенная технология Google распознала Тбилисскую телебашню, которую я сфотографировал издалека в условиях плохого освещения. Затем он предлагал ссылки на соответствующие веб-сайты и местные рекламные ролики, связанные с этим регионом. Это очень удобно для быстрого ознакомления с близлежащими местами и объектами, особенно когда времени мало.

С моей точки зрения, маловероятно, что технические препятствия помешают Apple включить Visual Intelligence в серию iPhone 15 Pro. Эта функция в основном зависит от возможностей серверов Google и ChatGPT, а не от интеллекта устройства. В отличие от других функций Apple Intelligence, которые могут работать в автономном режиме, для эффективной работы Visual Intelligence требуется постоянное подключение к Интернету. Более того, хотя в предыдущих моделях iPhone не было кнопки управления камерой, Apple могла бы легко представить эту функцию в виде ярлыка для кнопок действий или даже разработать для нее отдельное приложение.

Смотрите также

- 10 лучших чехлов, которые обязательно нужно иметь для вашего нового Samsung Galaxy S25 Ultra!

- Лучшие телефоны для людей, чувствительных к ШИМ/мерцанию, 2024 г.

- Первые 11 вещей, которые нужно сделать с Samsung Galaxy Watch Ultra

- 20 лучших рождественских ЛГБТ-фильмов всех времен

- Обзор Fiio SR11: доступный сетевой стример с интеграцией Roon

- Обзор Withings ScanWatch 2: красивые «умные часы» и не более того

- Samsung может наконец предоставить своему ящику приложений функцию, о которой все просили

- Лучшие телефоны Android для студентов 2024 года

- Обзор умных очков RayNeo Air 2S XR: повышение уровня

- Обзор Google TV Streamer: фантастика, но не идеально

2024-10-24 14:47