- Google рассказал о выпуске новой анкеты по оценке рисков SAIF для создателей систем искусственного интеллекта.

- В ходе оценки будет задан ряд подробных вопросов о модели искусственного интеллекта создателя и предоставлен полный «отчет о рисках» для потенциальных проблем безопасности.

- Google уделяет особое внимание безопасности и искусственному интеллекту, особенно после того, как он принес в Белый дом методы обеспечения безопасности с использованием искусственного интеллекта.

Как человек, ставший свидетелем быстрого развития технологий и их влияния на нашу повседневную жизнь, я должен сказать, что новая оценка рисков SAIF от Google для создателей систем искусственного интеллекта — это значительный шаг вперед в обеспечении безопасности и защищенности в сфере искусственного интеллекта. Занимаясь технологиями уже довольно давно, я могу подтвердить огромный потенциал, который таит в себе ИИ, а также потенциальные риски, которые он представляет, если к ним не подходить ответственно.

🎁 Бесплатные токены для настоящих охотников! Airdrop раздает халяву, которую ты точно не захочешь упустить.

Присоединиться в ТелеграмGoogle подчеркивает, что «потенциал ИИ огромен», поэтому для разработчиков систем ИИ вводится новая оценка рисков.

В статье в блоге Google объясняет, что оценка рисков SAIF призвана помочь разработчикам обеспечить соответствие их моделей ИИ необходимым рекомендациям по безопасности. Разработчики могут найти эту анкету в верхней части страницы SAIF на главной странице Google. Оценка рисков поможет им ответить на различные вопросы, связанные с их ИИ, охватывая такие аспекты, как обучение, тонкая настройка и оценка, генеративные агенты ИИ, контроль доступа, наборы данных и множество других тем.

Проще говоря, такая подробная анкета помогает инструменту Google создать точный и подходящий набор шагов для обеспечения безопасности программного обеспечения.

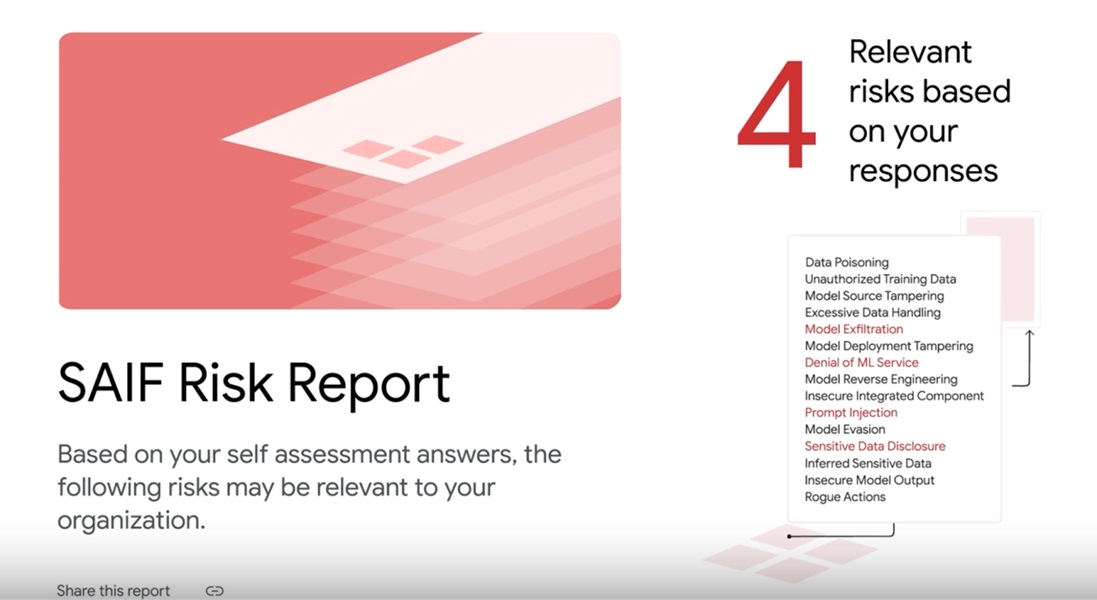

В сообщении говорится, что пользователи найдут подробный отчет о «конкретных» рисках для их системы искусственного интеллекта после завершения анкетирования. Google заявляет, что модели искусственного интеллекта могут быть подвержены таким рискам, как отравление данных, быстрое внедрение, подделка источника модели и многое другое. Оценка рисков также проинформирует создателей систем искусственного интеллекта, почему инструмент пометил определенную область как подверженную риску. В отчете также будут подробно описаны любые потенциальные «технические» риски.

Кроме того, в отчете будут предложены стратегии по минимизации этих рисков от перерастания в более крупные проблемы или потенциальные угрозы в будущем.

Google продемонстрировал прогресс, создав новую Коалицию за надежный ИИ (CoTAI). Как указано в их обновлении, Google объединилась с 35 крупными игроками отрасли, чтобы запустить три ключевых направления: безопасность цепочки поставок систем искусственного интеллекта, адаптация защитников к развивающемуся сценарию кибербезопасности и управление рисками, связанными с искусственным интеллектом. По утверждению Google, в этих «приоритетных секторах» CoTAI работает над разработкой практических решений безопасности на основе искусственного интеллекта.

Первоначально Google занял взвешенную и осторожную позицию, когда дело касалось приложений искусственного интеллекта (ИИ), и эта политика остается очевидной с введением оценки рисков SAIF. Примечательно, что они всегда отдавали приоритет ответственности за разработку и внедрение своего программного обеспечения для искусственного интеллекта. По их собственным словам: «Наш подход к ИИ должен быть одновременно инновационным и ответственным. Это означает создание технологии ИИ, которая принесет наибольшую пользу обществу и одновременно решит потенциальные проблемы.

С другой стороны, Google вместе с другими крупными технологическими компаниями добилась успехов в продвижении безопасных методов искусственного интеллекта. В 2023 году они представили эти методы Белому дому, сосредоточив внимание на мерах, которые позволят укрепить общественное доверие и повысить безопасность. Более того, Белый дом возложил на них роль по защите конфиденциальности людей, использующих их системы искусственного интеллекта.

Как исследователь, я могу поделиться тем, что директива Белого дома включила нашу компанию, среди прочих, в разработку и инвестирование мер кибербезопасности. Судя по всему, Google усердно выполняет этот мандат, поскольку их проект SAIF прошел путь от теоретического проекта до оперативного программного обеспечения.

Смотрите также

- 10 лучших чехлов, которые обязательно нужно иметь для вашего нового Samsung Galaxy S25 Ultra!

- Лучшие телефоны для людей, чувствительных к ШИМ/мерцанию, 2024 г.

- Первые 11 вещей, которые нужно сделать с Samsung Galaxy Watch Ultra

- Обзор Fiio SR11: доступный сетевой стример с интеграцией Roon

- 20 лучших рождественских ЛГБТ-фильмов всех времен

- Обзор Withings ScanWatch 2: красивые «умные часы» и не более того

- Обзор умных очков RayNeo Air 2S XR: повышение уровня

- Samsung может наконец предоставить своему ящику приложений функцию, о которой все просили

- Лучшие телефоны Android для студентов 2024 года

- Обзор Google TV Streamer: фантастика, но не идеально

2024-10-24 16:23