Обычно некоторые аниме адаптируются в фильмы или сериалы с живыми актерами с небольшим вниманием за пределами страны их происхождения, что означает, что многие зрители даже не знают, что они были созданы. Эти адаптации часто сжимают целые сюжетные арки в один фильм, разделяют повествования на несколько фильмов или меняют обстановку и предысторию персонажей, чтобы лучше соответствовать живой съёмке.

"Просто покупай индекс", говорили они. "Это надежно". Здесь мы обсуждаем, почему это не всегда так, и как жить с вечно красным портфелем.

Поверить в рынокВот пятнадцать игровых адаптаций, основанных на популярных аниме, включая как фильмы, так и стриминговые шоу. Для каждого из них мы рассмотрим важные детали того, как он был создан, где он отличается от оригинального аниме и как создатели фильма представили историю новой аудитории.

‘Parasyte: Part 1’ (2014)

Этот японский фильм, выпущенный в двух частях, переосмысливает жуткую концепцию аниме ‘Parasyte‘. Он рассказывает о Синичи и его первых столкновениях с этими странными существами, а также об уникальной связи, которую он устанавливает с Миги. Режиссёр – Такаси Ямазаки, в главных ролях – Сёта Сомэтани и Ай Хасимото, фильм был спродюсирован Toho. В фильме используется много специальных эффектов, чтобы оживить Миги и изменения, которые происходят с паразитами. Первая часть фильма показывает, как начинается история, и фокусируется на конфликтах в школе, одновременно намекая на большую тайну, которая продолжается во второй части.

Эта киноверсия ‘Parasyte’ упрощает роли второстепенных персонажей и ускоряет сюжет, чтобы уместить его в один фильм. Вместо того, чтобы сосредотачиваться на яркой анимации, в ней используются реальные локации в Токио и практические эффекты для изображения жестокости. Сценарий также меняет причины, по которым действуют некоторые персонажи, чтобы конфликты происходили быстрее. Второй фильм, вышедший в 2015 году, завершает историю, начатую первым фильмом, охватывая все события как из манги, так и из аниме.

‘Erased’ (2017)

Сериал ‘Erased’ в формате игрового кино берет захватывающую тайну путешествий во времени из аниме ‘Erased’ и расширяет ее в стриминговый сериал с несколькими эпизодами. Это позволяет истории следовать расследованию как в настоящем, так и в прошлом. В основном снятый на Хоккайдо и в Токио, сериал сохраняет основную идею способности главного героя «возрождаться» и придерживается того же порядка исчезновений и спасений, что и в оригинальной истории.

По сравнению с аниме ‘Erased’, этот сериал включает дополнительные сцены, которые глубже раскрывают события во взрослой жизни и делают отношения между второстепенными персонажами и центральной загадкой более понятными. Способ, которым история разбита на эпизоды, позволяет адаптации точно воссоздать важные моменты из исходного материала, а также предложить больше информации о подозреваемом и о том, как полиция ведет расследование. Такой подход помогает расследованию развиваться в темпе, схожем с живым драматическим сериалом.

‘Gintama’ (2017)

Фильм «‘Gintama’» передает уникальное сочетание истории и научной фантастики, найденное в аниме «‘Gintama’», пересказывая сюжетную арку Бенизакура. Снятый Юичи Фукудой с участием Сюна Огури, Масаки Суды и Канны Хасимото, фильм оживляет действие с помощью впечатляющих масштабных декораций, воссоздающих улицы эпохи Эдо, детализированных протезов для инопланетных персонажей и умелого использования тросов во время схваток на мечах, благодаря чему последовательности кажутся реалистичными.

Как большой поклонник Gintama, я всегда любил, как аниме смешивает забавные, самодостаточные эпизоды с более масштабными сюжетными линиями. Но фильм сразу же погружает в действие, быстро собирая всех главных персонажей и сосредотачивая всю историю на конфликте Бенизакуры. Они даже сделали продолжение в 2018 году, которое охватило больше материала из манги! Оба фильма отлично справляются со своей задачей, втискивая в себя все забавные повторяющиеся шутки и внутренние приколы, которые мы любим, при этом не забывая о важных частях сюжета. Словно они действительно поняли, что делает Gintama особенным, и смогли уместить все это в фильм!

‘Attack on Titan’ (2015)

Эта экранизация аниме ‘Attack on Titan’, основанная на начальной сюжетной арке Wall Maria, была выпущена в двух частях в 2015 году. Режиссёром выступил Синдзи Хигути, а в главных ролях снялись Харума Миура и Кико Мизухара, которые воплотили битвы с Титанами в жизнь, используя как реальные эффекты, так и цифровую графику. Съёмки проходили на натуре на острове Хасима и в других промышленных районах.

Фильмы вносят некоторые изменения в историю персонажей и добавляют новые детали, которых нет в аниме ‘Attack on Titan’, чтобы лучше работать как художественный фильм. Такие вещи, как военные технологии, способ использования оборудования и определенные отношения, представлены по-другому, чтобы поддерживать хороший темп повествования. Поскольку история рассказывается в двух частях, второй фильм развивает идеи битвы и контратаки, которые были впервые показаны в первой части.

‘Bleach’ (2018)

Этот фильм основан на сюжетной арке «Заместитель Шинигами» из аниме ‘Bleach’. В центре внимания — первая битва Ичиго Куросаки с Hollows и его сотрудничество с Рукией Кучики. Режиссёром фильма выступил Шинсуке Сато, а в главных ролях снялись Sota Fukushi и Hana Sugisaki. В фильме используются городские декорации, Hollows создаются с помощью цифровых эффектов, а боевые сцены напоминают ранние эпизоды аниме.

Аниме ‘Bleach’ имеет множество сюжетных арок и персонажей, но фильм упрощает ситуацию, сосредотачиваясь на Ичиго, Рукии и Бьякуе, создавая самостоятельную и полноценную историю. Сюжет фильма развивается к финальной битве, связанной со способностями и обязанностями Рукии, и он объясняет мир Soul Reapers постепенно, что позволяет зрителям, незнакомым с аниме, легко понять происходящее.

‘Fullmetal Alchemist’ (2017)

Фильм ‘Fullmetal Alchemist’ рассказывает о путешествии братьев Эльриков, как это показано в аниме ‘Fullmetal Alchemist’. Он воплощает в жизнь мир алхимии и automail с помощью компьютерной графики (CGI) и реальных декораций. Режиссёр Фумихико Сори, в главных ролях Рёсукэ Ямада и Цубаса Хонда, фильм был снят на натуре в Европе, чтобы точно воссоздать архитектуру из оригинальной истории. Это визуальная адаптация любимого аниме.

Аниме ‘Fullmetal Alchemist’ имеет сложный и разветвленный сюжет, поэтому фильм упрощает начало, концентрируясь на событиях, окружающих человеческую алхимию, экзамены на государственных алхимиков и тайнах Лаборатории 5. Два дополнительных фильма, выпущенных в 2022 году, продолжают историю, раскрывая важную информацию о гомункулах и демонстрируя решающие сражения, происходящие в городе, в конечном итоге завершая основную сюжетную линию.

‘Mob Psycho 100’ (2018)

Эта новая серия оживляет историю Mob Psycho 100 – сверхъестественную историю о взрослении – в виде стримингового драматического сериала. Tatsuomi Hamada играет Shigeo «Mob» Kageyama. Шоу воссоздает ключевые элементы из аниме, такие как школьная жизнь, миссии по охоте на призраков и сражения с другими психическими персонажами, используя сочетание практических эффектов (например, работы с тросами) и визуальных эффектов, разработанных для телевизионного сериала.

Аниме Mob Psycho 100 передает свой преувеличенный визуальный юмор на сцене благодаря продуманному дизайну декораций и визуальным эффектам, при этом отслеживая эмоциональное состояние Моба, используя его «процент» как сюжетный прием. Главные злодеи и события в клубе представлены в том же порядке, что и в первых эпизодах, но с более длинными разговорами, чтобы усилить ощущение реалистичности все более интенсивных психических сражений.

‘Kakegurui’ (2018–2019)

Этот игровой сериал основан на напряжённом мире школьных азартных игр, показанном в аниме ‘Kakegurui‘. В главных ролях Минами Хамабэ и Махиро Такасуги, которые переосмысливают структуру власти в школе и азартные игры. В каждом эпизоде представлена полноценная игра, и в сериале используются настоящие карты и доски, а также детализированная работа камеры, чтобы чётко показать, как работает система ставок.

По сравнению с аниме ‘Kakegurui’, этот сериал включает в себя новые соревнования и перестраивает некоторые игры, чтобы подчеркнуть организацию студенческого совета. Впоследствии было выпущено два спин-офф фильма, продолжающих соревнования из телешоу и развивающих сюжетные линии, такие как студенческие выборы и трудности, с которыми сталкиваются новые студенты — и все это в рамках одной общей истории.

«Невероятная жизнь Сайки К.» (2017)

Этот фильм основан на первом годе аниме-сериала ‘The Disastrous Life of Saiki K.‘. Kento Yamazaki исполняет роль Кусуо Сайки. Создатели фильма использовали реальные эффекты и компьютерную графику, чтобы продемонстрировать способности Сайки — такие как телепатия, телекинез и телепортация — пока он учится в школе и перемещается по городу. Это визуально креативная адаптация!

Аниме ‘The Disastrous Life of Saiki K.’ было адаптировано в фильм, где привычные короткие, самодостаточные истории переплетаются в один непрерывный сюжет. Фильм следует за теми же персонажами, которых мы встречаем в начале сериала, и использует ключевые моменты — демонстрируя их способности, семейную жизнь и школьные события — чтобы создать забавные сцены и запоминающиеся эпизоды в формате живого действия.

‘Death Note’ (2006)

Как критик, должен сказать, что первая японская лайв-экшн адаптация ‘Death Note‘ действительно углубляется в начало истории, которую мы все знаем по аниме. Tatsuya Fujiwara великолепен в роли Light Yagami, а Kenichi Matsuyama идеально передает загадочного L. Этот фильм явно был создан для большого экрана и сосредотачивается на тех ранних случаях, когда Kira впервые начинает устранять преступников, создании целевой группы, пытающейся его остановить, и, что важно, он излагает все правила этого невероятно мощного блокнота. Это верный пересказ тех начальных событий, безусловно.

Аниме ‘Death Note’ имеет несколько сюжетных арок, поэтому экранизация была разделена на две части, выпущенные в одном году, при этом второй фильм завершает центральный конфликт. В то время как спин-оффы и более поздние версии, созданные в других странах, пересказывают основную историю, два фильма 2006 года тесно следуют за первоначальной крупной битвой в аниме и тем, как правила Death Note впервые используются и исследуются.

‘Rurouni Kenshin Part I: Origins’ (2012)

Фильм ‘Rurouni Kenshin’ основан на сюжетной арке из Токио из аниме-сериала ‘Rurouni Kenshin’. Он показывает обещание Кеншина Химуры не убивать и знакомит с его друзьями в додзё Камия. Режиссёр Кэйси Отомо, в главных ролях Такеру Сато и Эми Такэй, фильм оживляет эпоху Мэйдзи с детализированными схватками на мечах, аутентичными декорациями и съёмками на натуре.

Более поздние фильмы, выпущенные с 2014 по 2021 год, продолжают историю, исследуя Киото и элементы предыстории, во многом как основные сюжетные арки в аниме ‘Rurouni Kenshin’. Первый фильм фокусируется на построении отношений между персонажами, объясняя, почему злодеи действуют так, как они это делают, и показывая, как работает полиция. Последующие фильмы затем увеличивают напряжение и представляют группы, которые подробно исследуются на протяжении нескольких сезонов аниме.

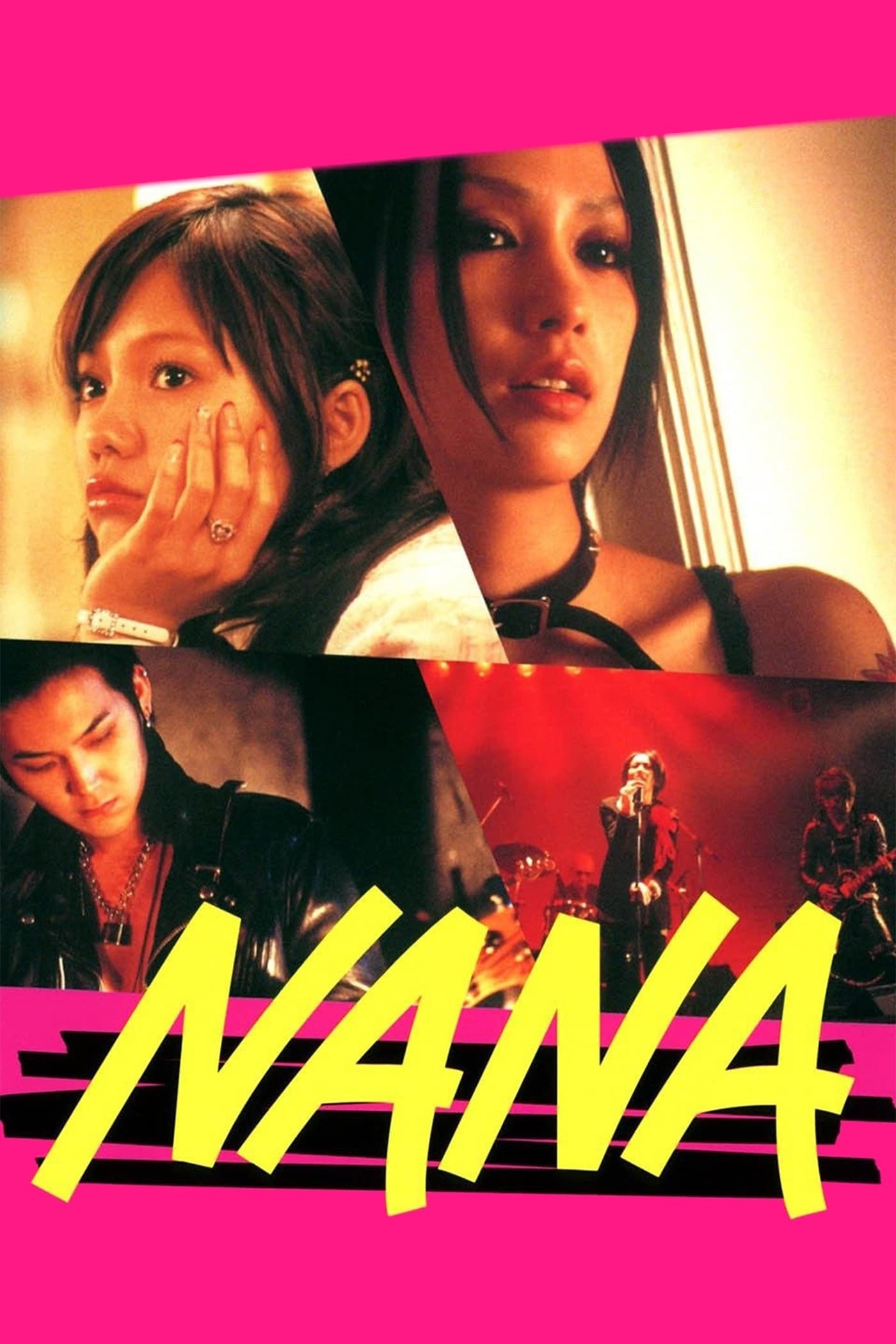

‘Nana’ (2005–2006)

Два фильма подряд оживляют музыку и эмоциональные истории из аниме ‘Nana’. Они рассказывают о переплетённых путях двух женщин, обеих по имени Нана, которые проходят через жизнь и делят квартиру в Токио. Mika Nakashima и Aoi Miyazaki исполняют главные роли. Фильмы содержат концертные сцены, снятые в реальных местах и студийных записях, чтобы показать развитие групп.

Аниме ‘Nana’ выпускается в виде двух полнометражных фильмов. Эти фильмы пересказывают те же ключевые события из сериала, такие как взаимодействие с лейблами звукозаписи, соперничество между группами и личная жизнь персонажей. Второй фильм продолжает с того места, на котором закончился первый, охватывая ту же территорию, что и средняя часть оригинального аниме — в частности, процесс записи группы и повышенное внимание со стороны средств массовой информации.

‘Chihayafuru: Part I’ (2016)

Этот лайв-экшн сериал из трех фильмов основан на соревновательном мире каруты из аниме Chihayafuru. Suzu Hirose играет Чихаю Аясэ, и фильмы показывают прогресс команды по мере их участия в местных и национальных турнирах. Турнирные сцены сняты с использованием настоящих карт каруты и быстрых монтажных переходов, чтобы показать, как быстро игроки читают и двигают руками.

Аниме Chihayafuru фокусируется на важных матчах и отношениях между тремя главными героями, упрощая сцены тренировок и формирования команды. Третий фильм, вышедший в 2018 году, завершает историю, начатую в первых двух фильмах. Он повторяет путь аниме от отборочных туров до главных чемпионских игр и представляет соперников, обладающих высочайшим мастерством.

‘Blade of the Immortal’ (2017)

Я был полностью очарован интерпретацией Такаси Миике ‘Blade of the Immortal’! Ему удалось перегнать эпическую историю мести из аниме в один невероятный фильм. Такуя Кимура и Хана Сугисаки феноменальны в главных ролях, а экшн-сцены просто захватывают дух. Хореография действительно подчеркивает эти долгие, затяжные фехтования, и они не побоялись использовать практические эффекты — много реалистичной крови, чтобы показать эти огромные сражения. Это действительно передаёт масштаб столкновений.

Аниме-сериал ‘Blade of the Immortal’ переставляет отдельные эпизоды, чтобы создать более мощное нарастание к центральному противостоянию, в конечном итоге разрешая основной конфликт. Фильм фокусируется на самых важных злодеях и сокращает путешествия, при этом сохраняя отношения между опытным учителем и учеником — ключевой элемент, который продвигает историю вперед благодаря тренировкам и неожиданным атакам во время их путешествий.

‘Black Butler’ (2014)

Этот фильм оживляет мир и персонажей аниме ‘Black Butler’. Он фокусируется на сделке, заключенной между молодым аристократом и его демоном-слугой. Фильм режисируют Кентаро Отани и Кейичи Сато, и он переосмысливает историю во времени, близком к нашему будущему. Hiro Mizushima играет роль Себастьяна.

Аниме ‘Black Butler’ происходит в викторианской Англии, но этот фильм обновляет визуальный стиль с помощью современной постановки. Тайна в фильме совершенно новая, созданная специально для этой адаптации. Важные части истории — такие как навыки дворецкого, особая печать и соглашение между хозяином и слугой — остаются прежними. Однако, второстепенные персонажи были изменены, чтобы лучше соответствовать обновленному периоду времени и самостоятельной истории фильма.

Поделитесь в комментариях экранизациями, которые вас больше всего удивили.

Смотрите также

- 10 лучших чехлов, которые обязательно нужно иметь для вашего нового Samsung Galaxy S25 Ultra!

- Элизабет Лайл выходит без бюстгальтера в прозрачном платье, ошеломляет на премьере ‘Five Nights at Freddy’s 2’.

- Первые 13 вещей, которые нужно сделать с OnePlus 13

- Подойдет ли Samsung Galaxy S25 к чехлам Galaxy S24?

- Вин Дизель показал новый образ из фильма «Риддик: Фурья», и он выглядит потрясающе!

- Вот все телефоны, которые поддерживают обходную зарядку, и почему вам следует ее использовать.

- Лучшие телефоны Android для студентов 2024 года

- Лучшие телефоны для людей, чувствительных к ШИМ/мерцанию, 2024 г.

- Обзор Fiio SR11: доступный сетевой стример с интеграцией Roon

- Первые 11 вещей, которые нужно сделать с Samsung Galaxy Watch Ultra

2025-10-02 13:48