Прошло чуть больше восьми лет с тех пор, как мы начали обсуждать Блоки Нейронной Обработки (NPUs) в смартфонах и потенциал запуска ИИ непосредственно на наших устройствах. Многие вспомнят HUAWEI Mate 10 с процессором Kirin 970 как первый, в котором была представлена эта технология, хотя подобные концепции уже изучались ранее, особенно в камерах смартфонов.

"Просто покупай индекс", говорили они. "Это надежно". Здесь мы обсуждаем, почему это не всегда так, и как жить с вечно красным портфелем.

Поверить в рынокЗа последние восемь лет произошло много событий. Apple начала использовать ИИ, хотя и не всегда успешно, а Google теперь сильно полагается на свои специализированные процессоры для таких вещей, как фотографии и перевод языков прямо на вашем телефоне. Если вы спросите любую крупную технологическую компанию – такую как Arm, Qualcomm, Apple или Samsung – все они согласятся, что ИИ является ключом к будущему смартфонов, как с точки зрения технологии внутри, так и программного обеспечения, которое вы используете.

Несмотря на растущую мощность процессоров для телефонов, предназначенных для ИИ, мобильный ИИ по-прежнему кажется ограниченным. Мы в основном видим лишь несколько функций, созданных Google, и не так много возможностей для разработчиков создавать собственные ИИ-возможности. Ключевая причина этого заключается в том, что эти специализированные процессоры, называемые NPU, не были по-настоящему открыты как платформа разработки. Это поднимает фундаментальный вопрос: для чего эти мощные чипы действительно лучше всего подходят?

Что такое NPU вообще?

![]()

Прежде чем решить, действительно ли телефонам нужен блок нейронных вычислений, давайте сначала разберемся, что он делает.

Представьте свой телефон: в нем есть основной процессор для приложений, графический процессор для игр и специальный процессор для фотографий и видео. NPU похож на него – это процессор, специально разработанный для выполнения задач ИИ как можно быстрее и эффективнее. Это выделенный ИИ-мозг для вашего устройства.

Нейронные процессоры (NPU) созданы для эффективной обработки небольших объемов данных – например, очень компактных 4-битных и 2-битных моделей – и преуспевают в повторяющихся задачах, связанных с вычислениями. Они особенно хороши в быстром выполнении операций одновременного умножения и сложения.

Мобильные блоки нейронных вычислений (NPU) получили распространение для выполнения задач искусственного интеллекта, с которыми традиционным процессорам трудно справиться.

Как я упоминал в 2017 году, выделенный NPU не всегда необходим для машинного обучения. Многие более простые алгоритмы могут отлично работать на стандартном CPU, а мощные серверы, которые запускают большие языковые модели, фактически полагаются на аппаратное обеспечение, аналогичное графическим картам NVIDIA, а не на NPU, которые можно найти в телефонах.

Выделенный блок нейронных вычислений (NPU) позволяет вашему устройству запускать продвинутые AI-модели, с которыми стандартный CPU или GPU могут испытывать трудности, и он часто делает это, потребляя меньше энергии. Хотя добавление NPU может усложнить сборку устройств, преимущества с точки зрения энергоэффективности и производительности значительны, особенно для смартфонов. Никто не хочет, чтобы AI-функции быстро разряжали аккумулятор телефона.

Подождите, но разве ИИ тоже не работает на видеокартах?

Как вы, возможно, слышали, цены на оперативную память в последнее время растут. Это в значительной степени связано с растущей потребностью в мощных компьютерах и графических картах – особенно тех, которые производятся NVIDIA – для поддержки искусственного интеллекта и крупных центров обработки данных, которые его используют.

Архитектура NVIDIA CUDA превосходно справляется как с задачами искусственного интеллекта, так и с графикой, поскольку она может выполнять множество вычислений одновременно. Её специализированные ‘tensor cores’ особенно хорошо подходят для ключевой операции – умножения и сложения чисел – над различными типами данных, даже с использованием меньших форматов данных, используемых в современных AI-моделях.

Я заметил, что современные мобильные графические процессоры, такие как чипы Mali и Adreno, отлично работают с 16-битными и даже 8-битными данными, и они могут выполнять множество вычислений одновременно. Однако они действительно испытывают трудности при запуске очень маленьких, сильно сжатых моделей – вещей, которые используют INT4 или даже более низкую точность. Как будто они *могут* поддерживать эти форматы, и у них есть мощность для быстрой обработки, но они не были разработаны с использованием ИИ в качестве основной задачи, поэтому они не очень эффективны в этом.

Мобильные графические процессоры делают упор на эффективность; они значительно менее мощные для ИИ, чем их настольные аналоги.

Мобильные графические чипы приоритезируют экономию заряда батареи, в отличие от мощных GPU, найденных в настольных компьютерах. Они достигают этого с помощью таких методов, как разбиение изображений на меньшие тайлы и использование меньших вычислительных блоков, которые не идеальны для требовательных, непрерывных задач. Хотя мобильные GPU могут справляться с работой с искусственным интеллектом и показывать хорошие результаты в определенных сценариях, выделенное оборудование часто обеспечивает лучшую производительность на ватт для специализированных операций ИИ.

Так же важна, как и аппаратная часть, разработка программного обеспечения играет решающую роль. Инструментарий CUDA от NVIDIA предоставляет разработчикам детальный контроль над аппаратным обеспечением, позволяя им точно настраивать AI-программы для достижения максимальной производительности. Однако мобильные устройства не предлагают такого же уровня доступа. Вместо этого разработчики и производители полагаются на более простые, часто фирменные инструменты, такие как Neural Processing SDK от Qualcomm или Compute Library от Arm.

Разработка ИИ для мобильных устройств сложна, поскольку смартфоны используют множество различных типов процессоров, называемых NPU. В отличие от настольных компьютеров, которые в основном полагаются на NVIDIA’s CUDA (с набирающим популярность AMD’s ROCm), мобильные устройства имеют широкий спектр вариантов, таких как Google’s Tensor, Snapdragon’s Hexagon и Apple’s Neural Engine – каждый из которых требует уникальных подходов к разработке и платформ.

NPU не решили проблему с платформой.

Современные чипы для смартфонов включают в себя NPUs – специализированные процессоры, разработанные для обработки сложных задач, связанных с небольшими данными и сложными вычислениями, эффективно, без необходимости модернизации графического процессора. Однако эти отдельные NPUs создают новые препятствия, особенно для разработчиков, создающих приложения и программное обеспечение.

Раньше разработчикам приходилось создавать и настраивать приложения по отдельности для разных мобильных чипов, таких как чипы от Apple, Snapdragon и MediaTek. Даже Google не упростил доступ к возможностям искусственного интеллекта своих телефонов Pixel. Их Tensor ML SDK все еще находится в стадии эксперимента и может быть не выпущен в широком доступе. Хотя разработчики могут использовать Google’s ML Kit, чтобы попробовать некоторые базовые функции искусственного интеллекта, он не предлагает глубокого, прямого контроля над аппаратным обеспечением телефона, который многие предпочли бы.

Чтобы усугубить ситуацию, Samsung прекратила поддержку своего комплекта для разработки ИИ, а альтернативная система Google теперь устарела. Это создало запутанную неразбериху с техническими деталями и прекращенными инструментами, что сильно затрудняет разработку эффективных ИИ-приложений для мобильных устройств независимыми разработчиками. Опора на улучшения, специфичные для каждого производителя телефонов, не была устойчивым решением, и теперь мы в основном ограничены небольшими ИИ-моделями, работающими через облако или разработанными горсткой крупных компаний, таких как Google.

LiteRT запускает ИИ на устройстве в Android, iOS, Web, IoT и PC окружениях.

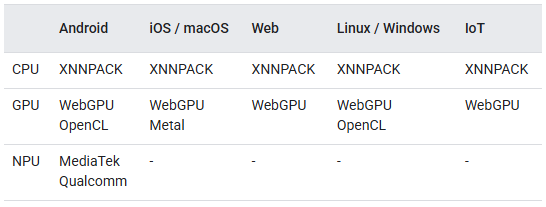

В 2024 году Google запустила LiteRT, который, по сути, заменяет TensorFlow Lite, как единую систему для запуска моделей ИИ непосредственно на устройствах. Она работает с CPU, GPU и специализированными процессорами от Qualcomm и MediaTek, и разработана для достижения максимально возможной производительности за счет автоматического выбора наилучшего оборудования. Это решает серьезную проблему с предыдущей системой, NNAPI, которая определяла *как* получать доступ к оборудованию, но не гарантировала стабильную производительность или надежность, поскольку полагалась на драйверы отдельных производителей оборудования. LiteRT стремится исправить это, полностью контролируя само окружение выполнения.

LiteRT разработан для запуска задач ИИ непосредственно на различных устройствах – от смартфонов (Android и iOS) и небольших встроенных систем до традиционных компьютеров. Это показывает, что Google хочет создать единую систему для запуска небольших AI-моделей на любой платформе. Однако, в отличие от многих AI-инструментов для компьютеров, TensorFlow Lite модели полностью настроены и оптимизированы *перед* их запуском. Решения о скорости, размере и способе работы модели принимаются заранее, чтобы обеспечить надежную производительность на устройствах с ограниченной вычислительной мощностью.

Главное преимущество LiteRT заключается в том, что он скрывает конкретный тип используемого NPU, но всё равно стоит задуматься о том, будут ли NPU такими важными в будущем, учитывая новые технологии, которые появляются сейчас.

Новое расширение SME2 от Arm значительно повышает производительность ИИ – до четырех раз быстрее для определенных задач – на его новейших процессорах серии C1, и оно работает с большинством программного обеспечения ИИ без необходимости использования специальных инструментов программирования. Мы также можем увидеть изменения в мобильных графических чипах для лучшей обработки ИИ, что потенциально сделает отдельные блоки обработки ИИ ненужными. Сообщается, что Samsung разрабатывает собственную графическую технологию, ориентированную на ИИ на устройстве, и она может появиться в телефонах Galaxy S28. Аналогично, чипы E-серии от Imagination разработаны для ускорения задач ИИ, поддерживая новые, эффективные форматы данных. Телефоны Google Pixel могут в конечном итоге использовать эти типы чипов.

LiteRT основывается на последних улучшениях в аппаратном обеспечении для машинного обучения, позволяя разработчикам сосредоточиться на создании приложений, не углубляясь в детали конкретных устройств. Поскольку процессоры становятся все более способными обрабатывать задачи машинного обучения, а графические процессоры получают улучшенную поддержку квантования, LiteRT может адаптироваться к тому, какое оборудование станет доминирующим – потенциально даже сделав графические процессоры основными ускорителями вместо специализированных NPU. Это делает LiteRT похожим на CUDA, но для мобильных устройств – он не полагается на конкретные аппаратные функции, а вместо этого предоставляет чистый, абстрактный слой, который работает на разных платформах.

Выделенные мобильные НПУ, вероятно, не исчезнут, но приложения, наконец, могут начать использовать их.

Хотя специализированные AI-чипы (NPUs) никуда не денутся, текущая тенденция компаний к привязке AI-функций к своим собственным чипам не является долгосрочным решением. Для большинства приложений традиционные процессоры (CPU и GPU) будут продолжать обрабатывать основную часть AI-задач, особенно по мере того, как они становятся лучше в выполнении машинного обучения. В конечном счете, программное обеспечение, которое управляет тем, как это оборудование используется, важнее самих чипов.

Если LiteRT будет работать хорошо, Neural Processing Units (NPUs) просто увеличат производительность ИИ, а не будут контролировать, что возможно. Это означает, что разработчики смогут создавать AI-функции для телефонов, не привязываясь к планам конкретного производителя чипов. Хотя полный спектр сторонних AI-функций ещё предстоит ждать, мы определённо продвигаемся к этой цели.

Смотрите также

- Разбор этой масштабной сцены с полным видом Рыцаря Семи Королевств.

- 10 лучших чехлов, которые обязательно нужно иметь для вашего нового Samsung Galaxy S25 Ultra!

- Лучшие телефоны для людей, чувствительных к ШИМ/мерцанию, 2024 г.

- YouTube дает сбой — что делать, если в вашей ленте застрял NaN:NaN

- Поддерживает ли Samsung Galaxy S24 FE eSIM и две SIM-карты?

- Практический опыт Samsung Galaxy Ring: Оуре стоит волноваться

- Порнореклама снова появляется на YouTube, несмотря на обещания Google сделать все возможное, чтобы остановить ее

- Обзор гоночного комплекта MOZA R3 (Xbox/ПК)

- Практический опыт: гибридные беспроводные наушники AKG N9

- Обзор умных очков RayNeo Air 2S XR: повышение уровня

2026-01-18 16:20