TLDR

- Среди основных систем сводок новостей на основе ИИ, Google Gemini показал наихудшие результаты, демонстрируя значительные проблемы во многих случаях.

- Gemini испытывал трудности с определением надёжных источников, предоставлением цитат и ссылками на исходные материалы.

- В то время как инструменты всех остальных демонстрируют признаки улучшения, Gemini всё ещё отстаёт.

Невозможно говорить об искусственном интеллекте, не обсудив в конечном итоге его ошибки. Хотя ИИ отлично справляется с организацией информации и может создавать удивительно качественный контент, он также склонен к ошибкам. Несмотря на то, что ИИ улучшился с тех пор, как был в своих ранних, ненадежных днях – вспомните странные результаты из Google AI Overviews? – важно спросить, какой прогресс был достигнут *действительно*. Недавние исследования начинают проливать свет на этот вопрос, и результаты немного беспокоят.

"Просто покупай индекс", говорили они. "Это надежно". Здесь мы обсуждаем, почему это не всегда так, и как жить с вечно красным портфелем.

Поверить в рынокЕвропейский вещательный союз (EBU) и BBC хотели оценить, насколько хорошо системы искусственного интеллекта – такие как ChatGPT, Gemini, Copilot и Perplexity – создают новостные сводки. Это особенно важно, потому что многие молодые люди (15% из числа людей младше 25 лет) теперь получают свои новости из ИИ. BBC сначала провела масштабный опрос и провела шесть фокус-групп, чтобы понять опыт и мысли людей об этих системах. Это исследование затем было расширено EBU для более масштабного международного исследования.

Исследование показало, что около 42% взрослых в Великобритании доверяют точности AI, и это доверие выше среди молодежи. Точность является основной проблемой для них – 84% говорят, что потеряют доверие, если AI допустит фактические ошибки. Однако стоит спросить, сколько информации, предоставляемой AI, на самом деле неверно, и замечают ли люди эти ошибки.

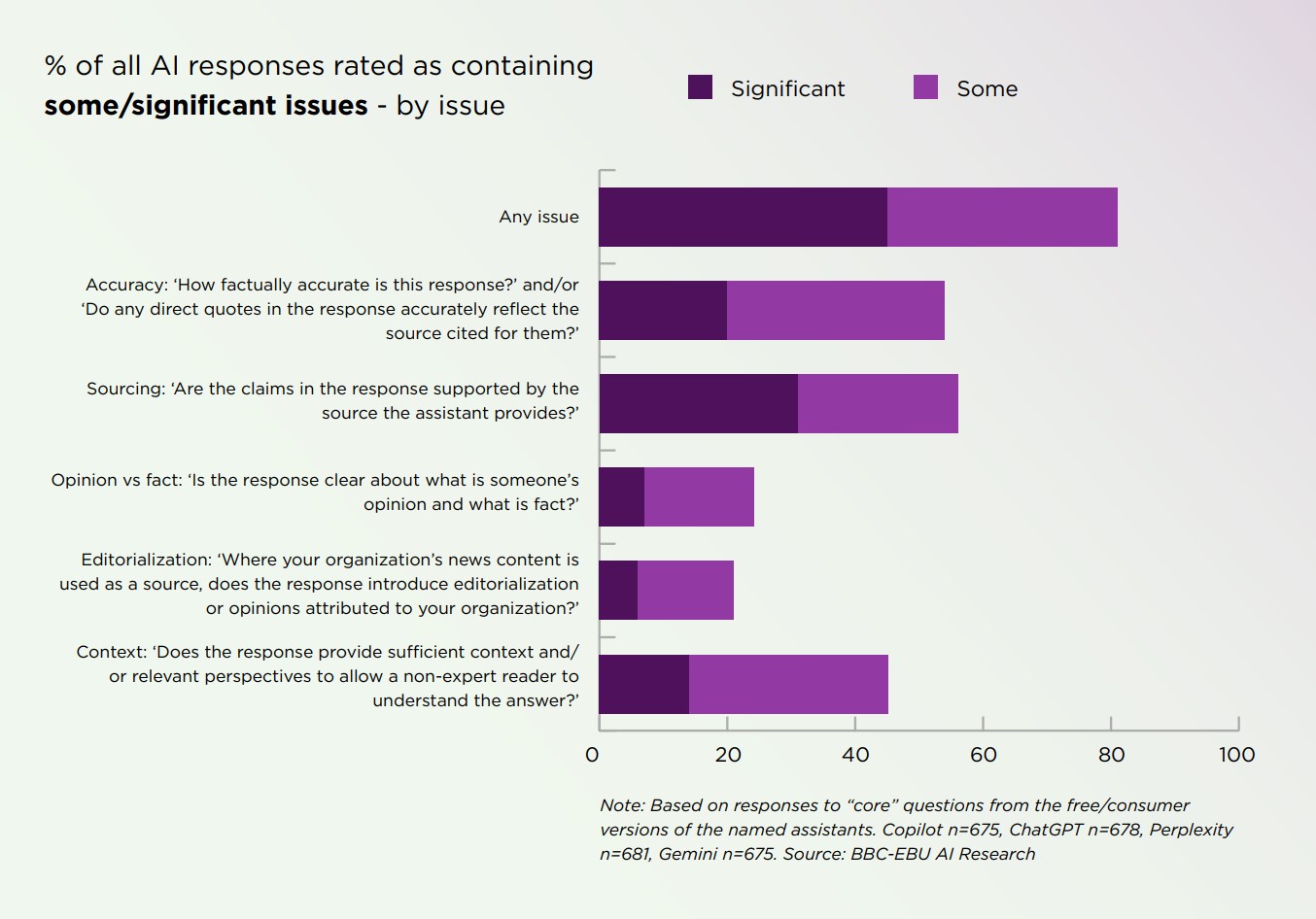

По результатам моих исследований, первоначальные данные указывают на то, что ответ в основном ‘нет’. Значительное количество ответов, сгенерированных ИИ, содержали проблемы того или иного рода, что привело меня к этому выводу.

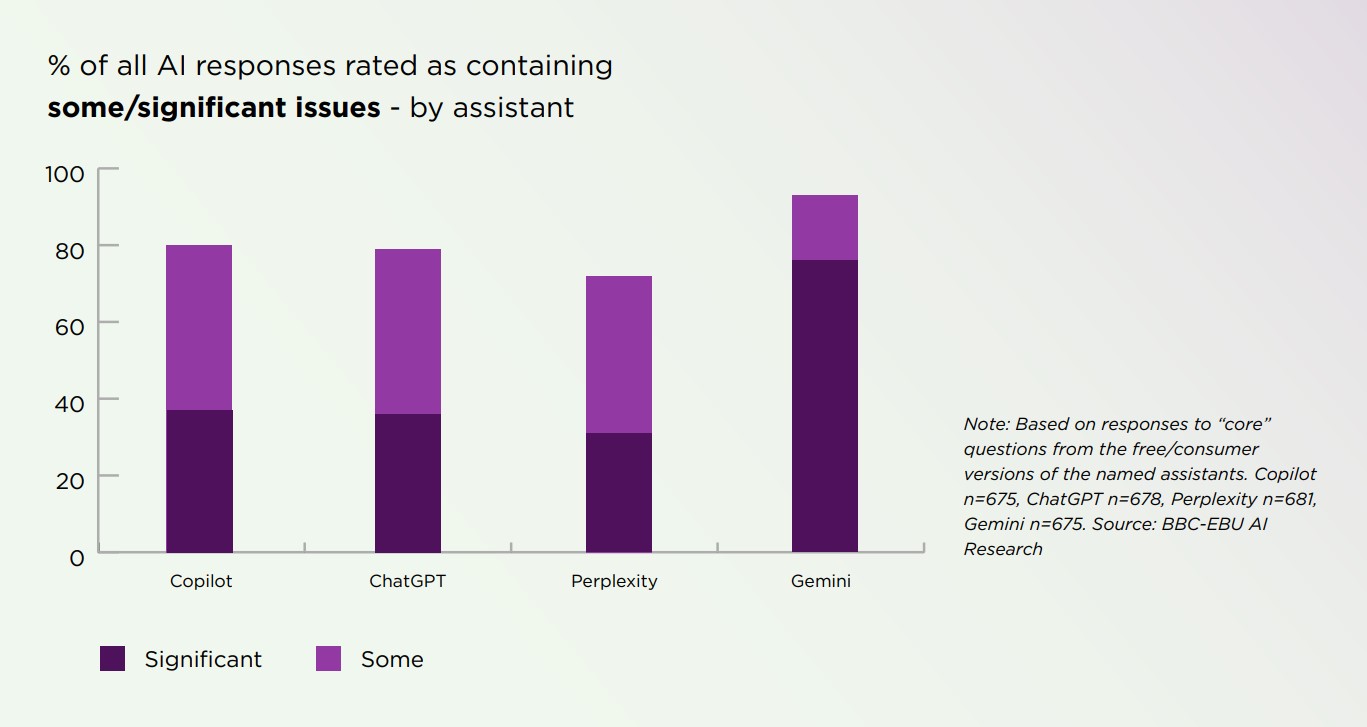

Протестированные нами модели не показали выдающихся результатов, и у большинства из них были схожие показатели. Однако Gemini значительно выделялся – у него было гораздо больше проблем в целом, и, что более важно, большая доля этих проблем была серьезной.

Gemini испытывает трудности с несколькими ключевыми проблемами. Исследователи обнаружили, что она нечётко показывает, откуда берется ее информация, часто смешивает достоверные источники с сатирой и слишком сильно полагается на Wikipedia. Ей также трудно понимать общую картину, и она иногда искажает прямые цитаты.

ИИ-системы, использованные в этом исследовании, стали лучше суммировать новости за шесть месяцев. Gemini, в частности, значительно улучшился. Однако, даже с этими достижениями, Gemini по-прежнему допускает значительно больше ошибок в своих сводках по сравнению с другими аналогичными системами.

Если вам хоть немного интересно, как мы взаимодействуем с новостями, созданными с использованием искусственного интеллекта, полный отчёт EBU стоит потраченного времени. Это критически важное чтение, которое может заставить вас пересмотреть, насколько вы доверяете новостям, сгенерированным ИИ, и если нет, то стоит вернуться к нему.

Мы связались с Google, чтобы узнать их реакцию на представленную информацию, и поделимся любым полученным ответом.

Смотрите также

- Лучшие защитные стекла для экрана Samsung Galaxy S25 FE 2025 года

- 10 лучших чехлов, которые обязательно нужно иметь для вашего нового Samsung Galaxy S25 Ultra!

- 30 лучших фильмов об обмене парой и женой, которые вам нужно посмотреть

- Лучшие телефоны для людей, чувствительных к ШИМ/мерцанию, 2024 г.

- Лучшие телефоны Android для студентов 2024 года

- Разбор этой масштабной сцены с полным видом Рыцаря Семи Королевств.

- Недорогие среднебюджетные телефоны Motorola образца 2026 года начинают появляться на утечках рендеров.

- Как долго бить все еще пробуждает глубину?

- Поддерживает ли Samsung Galaxy S24 FE eSIM и две SIM-карты?

- Я положил Bluetooth-динамик для сна под подушку, и это намного лучше, чем слушать на телефоне перед сном.

2025-10-24 00:18