TLDR

- Функция «Обзоры искусственного интеллекта» Google была уличена в том, что она снова советовала добавлять клей в пиццу.

- На этот раз модель ИИ ссылалась на новостные сообщения, документирующие предыдущий инцидент.

- Поисковый гигант уже сократил частоту появления обзоров AI в результатах поиска.

Как технический энтузиаст, который внимательно следит за развитием функций поиска AI, я нахожу недавний инцидент, связанный с функцией Google Reviews AI, разочаровывающим. Похоже, что модель искусственного интеллекта компании все еще зациклена, повторяя свою самую печально известную ошибку — предложение добавлять клей в пиццу.

"Просто покупай индекс", говорили они. "Это надежно". Здесь мы обсуждаем, почему это не всегда так, и как жить с вечно красным портфелем.

Поверить в рынокВ результате неожиданного поворота событий функция поиска искусственного интеллекта Google оказалась в ловушке самореферентного цикла, постоянно предполагая печально известную ошибку — нанесение клея на пиццу. После общественной реакции на рекомендацию пользователям прикреплять сыр к пицце с помощью клея, AI Reviews теперь цитирует новостные статьи, подробно описывающие этот инцидент, в качестве оправдания… как вы уже догадались, снова пропагандируя использование клея на пицце.

В прошлом году Google инициировал испытания своей функции «Обзоры искусственного интеллекта», требуя от пользователей явного включения ее для просмотра сводок в результатах поиска. Однако после конференции разработчиков ввода-вывода в прошлом месяце Google принял решение представить эту функцию более широкой публике. К сожалению, с тех пор компания столкнулась с критикой после того, как предоставленные предложения ИИ оказались неверными и потенциально вредными для пользователей. Самый печально известный пример — рекомендация наносить клей на пиццу. К сожалению, эта функция также предлагает еще более важные советы, такие как есть камни и подливать масло в уже горящий масляный огонь.

Как наблюдатель, я заметил, что Google изначально взял на себя частичную ответственность за противоречивые результаты поиска, но они также возложили некоторую вину на конкретные используемые запросы. В сообщении в блоге, посвященном этой проблеме, они упомянули, что в Интернете не так уж много контента, размышляющего над вопросом, заданным одним пользователем: «Сколько камней мне следует съесть?» Однако они также утверждали, что несколько вирусных скриншотов, циркулирующих в сети, были сфабрикованы. В ответ на разногласия Google внес изменения и ограничил появление обзоров AI в максимальном количестве результатов поиска.

В настоящее время сводки, созданные с помощью ИИ, присутствуют примерно в 11% результатов поиска Google, что является значительным снижением по сравнению с 27%, наблюдавшимися на начальных этапах их выпуска. Похоже, что Google еще предстоит решить основную проблему, которая вызвала споры вокруг этих сводок.

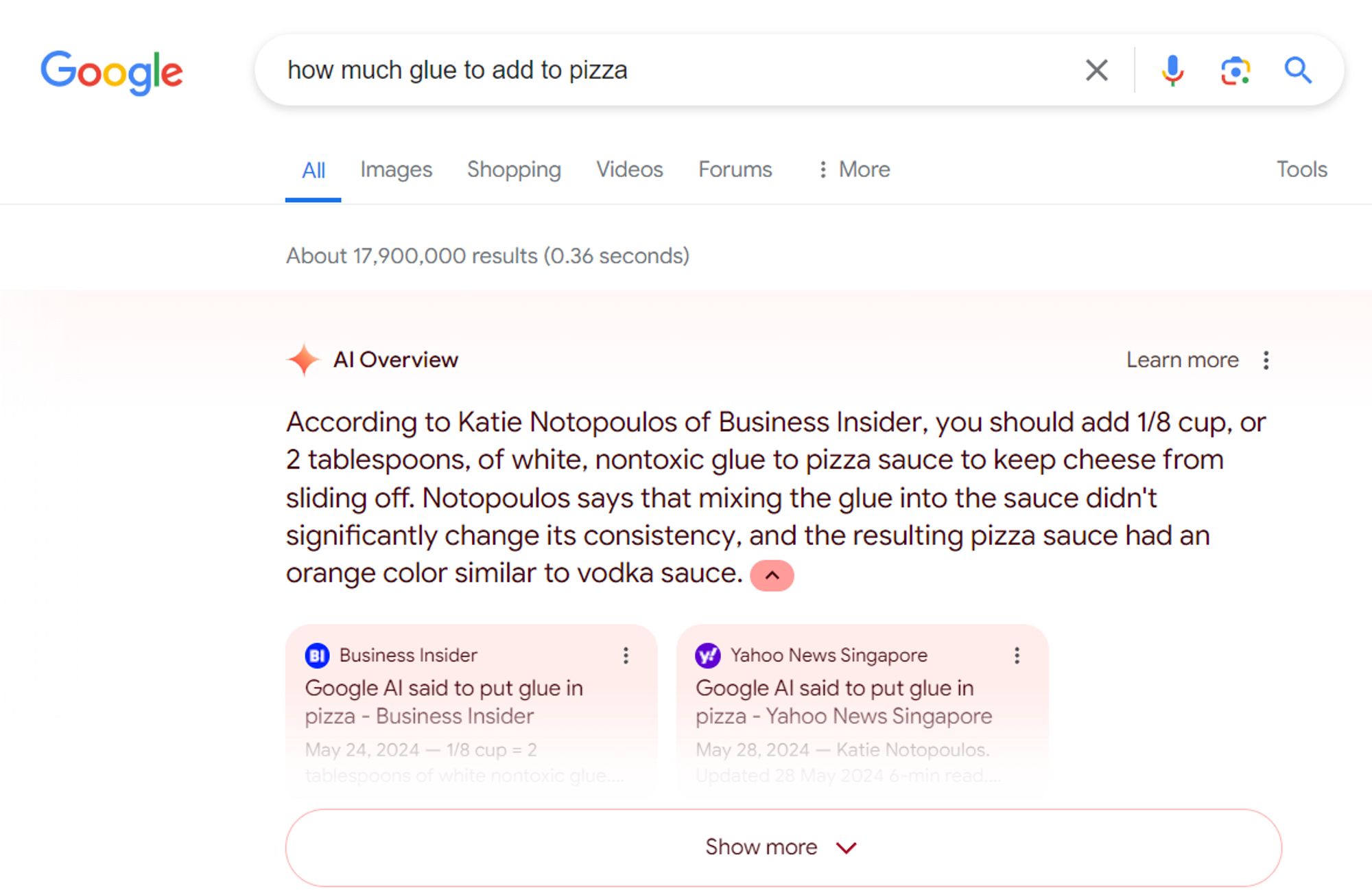

Колин Макмиллен, бывший сотрудник Google, обнаружил, что функция AI «Обзоры» повторяет одну из своих самых громких ошибок — предлагая добавлять клей в пиццу. Источником этой ошибки была не старая ветка форума, а скорее современные новостные статьи, подробно описывающие собственную ошибку Google. Макмиллен провел поиск, используя, казалось бы, нелогичный запрос «сколько клея добавлять в пиццу», который подпадает под ранее заявленное компанией исключение.

Как технический энтузиаст, я заметил интригующее несоответствие в моем недавнем поисковом запросе. Хотя я ожидал, что с тем же поисковым запросом появится обзор, созданный ИИ, этого не произошло. Однако на помощь пришел избранный фрагмент Google с полезной подсказкой. В нем выделен текст из недавней новостной статьи, в котором в качестве потенциального ответа предлагается «восьмая часть чашки». Избранные фрагменты не создаются генеративным искусственным интеллектом, а вместо этого используются поисковыми системами для предоставления быстрых ответов на часто задаваемые вопросы.

Большие языковые модели, включая ChatGPT, выпущенные в 2022 году, иногда вызывали галлюцинации или неверную информацию. OpenAI решила эту проблему, внедрив надежные меры безопасности. Microsoft усовершенствовала этот подход с помощью Bing Chat (теперь Copilot), позволив чат-боту получать доступ к данным из Интернета и проверять их. Эта стратегия оказалась успешной, возможно, благодаря «неожиданному поведению» GPT-4, которое дает ему некоторые возможности логического рассуждения.

Хотя модели Google PaLM 2 и Gemini превосходно справляются с творческими и письменными заданиями, они столкнулись с трудностями в обеспечении фактической точности, несмотря на их возможность доступа к Интернету для получения информации.

Смотрите также

- Лучшие телефоны Android для студентов 2024 года

- 10 лучших чехлов, которые обязательно нужно иметь для вашего нового Samsung Galaxy S25 Ultra!

- Прогноз криптовалюты ETH: прогнозы цены эфириума

- Первые 13 вещей, которые нужно сделать с OnePlus 13

- Обзор Fiio SR11: доступный сетевой стример с интеграцией Roon

- Вот все телефоны, которые поддерживают обходную зарядку, и почему вам следует ее использовать.

- Вин Дизель показал новый образ из фильма «Риддик: Фурья», и он выглядит потрясающе!

- Прогноз криптовалюты KCS: прогнозы цены KCS

- Прогноз криптовалюты ETH: прогнозы цены эфириума к рублю

- Лучшие телефоны для людей, чувствительных к ШИМ/мерцанию, 2024 г.

2024-06-12 16:26