Как аналитик с опытом работы в области технологий и искусственного интеллекта, я считаю, что новая функция Google «Обзоры искусственного интеллекта» вызывает беспокойство, основываясь на недавних сообщениях о неточных и потенциально опасных ответах. Проблема заключается в том, что результаты поиска не всегда являются надежным источником информации, а сводка ИИ может изрыгать контент с ненадежных сайтов.

"Просто покупай индекс", говорили они. "Это надежно". Здесь мы обсуждаем, почему это не всегда так, и как жить с вечно красным портфелем.

Поверить в рынокНа этой неделе Google представил в США функцию «Обзоры искусственного интеллекта», результаты которой оказались далеко не идеальными. Хотя цель этого нововведения состоит в том, чтобы улучшить некоторые поисковые запросы Google, предоставляя ответы на запросы, генерируемые искусственным интеллектом, тем самым избавляя пользователей от дополнительных кликов, реальность далека от совершенства. Вместо этого ответы варьировались от забавных и странных до неточных и даже потенциально опасных, что побудило Google серьезно пересмотреть эту новую функцию.

Проблема заключается в подходе Google, который предполагает сжатие информации из некоторых лучших результатов поиска по данному запросу. Однако важно отметить, что эти результаты не ранжируются на основе точности. Вместо этого на их размещение могут влиять такие факторы, как популярность и эффективные методы SEO. Хотя каждый веб-сайт несет ответственность за предоставление точной информации своим посетителям, существует риск того, что сводки, созданные с помощью искусственного интеллекта Google, могут содержать вводящий в заблуждение или вредный контент. В конечном итоге Google несет ответственность за достоверность этой информации.

Основатель The Onion Тим Кек (@oneunderscore__) вчера привел пример этого на X. В его посте на первом скриншоте был показан ответ на поисковый запрос «Сколько камней мне следует съедать каждый день?» в котором в обзоре AI Review говорилось: «По мнению геологов Калифорнийского университета в Беркли, люди должны съедать хотя бы один небольшой камень в день».

На втором снимке заголовок статьи из моей собственной публикации привлек мое внимание в результатах поиска, предоставленных ИИ Google. Однако важно отметить, что The Onion — известный источник сатирических новостей, известный своим юмористическим и художественным содержанием. Поэтому, хотя их статьи могут появляться в верхней части поисковых запросов Google по уникальным запросам, им не следует доверять в плане диетических или медицинских советов.

В широко распространенном примере из X Питер Ян (@peteryang) демонстрирует, как обзор искусственного интеллекта Google неправильно предложил добавить «1/8 стакана нетоксичного клея в соус» в ответ на запрос «сыр не прилипает к пицце». Ян рассказывает, что этот сомнительный совет, похоже, возник из сообщения на Reddit 11-летней давности пользователя по имени f***smith.

Несмотря на забавный характер последней ошибки Google с новой функцией, технологическому гиганту следует отнестись к этой проблеме серьезно. Большинство из нас, возможно, интуитивно знают, что нельзя употреблять несъедобные предметы, такие как клей или камни. Однако важно помнить, что не каждый может обладать этим фундаментальным уровнем рассуждения. Более того, другие ошибочные предложения искусственного интеллекта Google могут оказаться более убедительными и потенциально привести людей к опасности.

Как часто AI Обзор отвечает на подобные вопросы?

На данный момент не каждый поисковый запрос приводит к обзорному ответу от Google, сгенерированному ИИ. Если бы Google скорректировал эту функцию, исключив ее из медицинских и финансовых запросов, это могло бы стать шагом к решению, но этого еще не произошло.

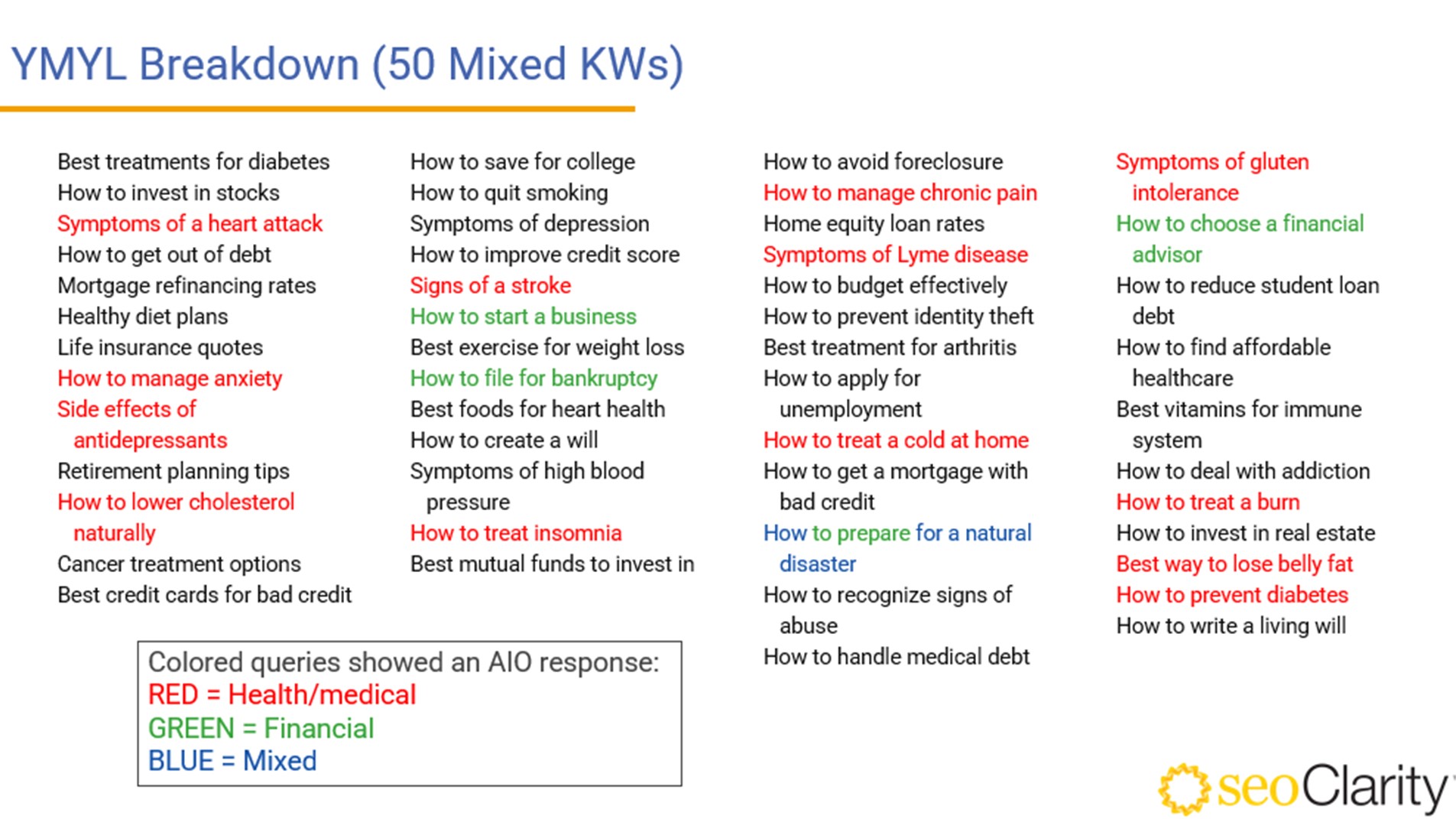

В своем исследовании я провел 50 поисковых запросов по темам финансов и здравоохранения, чтобы оценить, сколько из них даст машинный обзор.)

Примерно каждый третий запрос приводил к ответу, сгенерированному ИИ. Значительная часть этих запросов касалась вопросов здоровья или медицинских вопросов, таких как «симптомы инсульта» и «первая помощь при ожогах». Эти запросы могут быть срочными и иметь потенциальные последствия для благополучия пользователя. Точность и актуальность ответа ИИ в этих случаях могут существенно повлиять на действия и результаты пользователя.

В чем еще ошибка Google AI Review?

Существенный недостаток искусственного интеллекта Google вызывает широкую критику в Интернете, о чем свидетельствуют многочисленные скриншоты, распространяемые в Обзоре искусственного интеллекта, дающие неверные или вводящие в заблуждение медицинские советы или ответы на запросы. Например:

Как помощник, то есть наблюдатель, я хотел бы отметить, что рекомендация пользователя @dril под ником «Обзор AI» в лучшем случае сомнительна, когда дело касается советов по здоровью. В частности, они предлагают выпивать не менее двух литров мочи в течение 24 часов. Это предложение противоречит элементарной гигиене и здравоохранению.

В особенно тревожном сценарии пользователь Твиттера Гэри (@allgarbled) поделился изображением ответа ИИ на запрос «Я чувствую депрессию», который предлагал самоубийство в качестве варианта. Хотя ИИ признал, что рекомендация исходила от пользователя Reddit, было бы разумнее не поднимать этот вопрос в столь деликатном контексте.

Три. Вредные для здоровья рекомендации не ограничиваются людьми. @napalmtrees делится обзором искусственного интеллекта, подразумевая, что оставлять собаку в горячей машине безвредно. Он подтверждает это утверждение, ссылаясь на песню Битлз с таким же названием. Однако это не тот существенный аргумент, который преследует модель, и вызывает обеспокоенность по поводу ее сомнительных источников.

Это кажется удивительным, но, по данным AI Review, в игре НБА могла участвовать собака. Пользователь Патрик Космос (@veryimportant) обнаружил это интригующее открытие.

Как человек, разбирающийся в технологиях, я недавно наткнулся на интригующую статью Джо Маринга (@JoeMaring1) о X, где он делится зловещей интерпретацией гибели Сэнди Чикс из «Губки Боба Квадратные Штаны», представленной AI Review. Удивительно, но я не помню этот конкретный эпизод.

Что должно произойти сейчас?

Крайне важно, чтобы Google пересмотрела возможность сохранения публичной доступности функции «Обзор ИИ» до тех пор, пока она не пройдет тщательное тестирование, учитывая многочисленные проблемные примеры, которые появились. Эти примеры не только предоставляют неудовлетворительные и потенциально опасные рекомендации, но и представляют риск для репутации компании в отрасли, где высоко ценится передовой искусственный интеллект.

Как мы уже упоминали ранее, причина сбора необработанных результатов ясна. Неудивительно, что Google стремится выпустить эту функцию, учитывая, что другие языковые модели, такие как ChatGPT, дают ответы быстрее, чем традиционные методы поисковых систем. Однако что меня сбивает с толку в обзоре AI, так это очевидное отсутствие возможности самостоятельно оценивать тщательно подобранные ответы. Чтобы внести ясность: я ожидаю, что сложный ИИ не только определит, что существует ответ, предлагающий людям потреблять камни, но и отвергнет его, потому что камни несъедобны. Возможно, это моя непрофессиональная точка зрения, но ответственность за разработку решения лежит на экспертах Google.

Как технический энтузиаст, я бы порекомендовал рассмотреть предложение Эндрю Граша из AndroidAuthority: отключить функцию обзора AI, если вы не используете ее активно, пока Google не выпустит обновление.

Смотрите также

- 10 лучших чехлов, которые обязательно нужно иметь для вашего нового Samsung Galaxy S25 Ultra!

- Первые 11 вещей, которые нужно сделать с Samsung Galaxy Watch Ultra

- Лучшие телефоны для людей, чувствительных к ШИМ/мерцанию, 2024 г.

- Какой цвет Galaxy S24 лучший? Мы проверили их все

- Лучшие телефоны Android для студентов 2024 года

- Обзор XGIMI MoGo 3 Pro: поднимаем планку портативных проекторов

- Обзор Fiio SR11: доступный сетевой стример с интеграцией Roon

- Обзор Google TV Streamer: фантастика, но не идеально

- Лучшие фильмы десятилетия в формате Dolby Atmos (на данный момент) для проверки вашего домашнего кинотеатра

- Подойдет ли Samsung Galaxy S25 к чехлам Galaxy S24?

2024-05-24 22:11