Хотя облачные решения ИИ впечатляют, я обнаруживаю, что тоскую по повышенной безопасности, предлагаемой офлайновой локальной обработкой, особенно с учетом недавних опасений по поводу передачи пользовательских данных DeepSeek в Китай. Вчерашний переход с CoPilot на DeepSeek на моем ноутбуке вызвал мысль: возможно ли использовать большие языковые модели без подключения к Интернету и на смартфоне? Учитывая мощное оборудование, установленное в современных флагманских телефонах, — в комплекте с большим объемом оперативной памяти, ускорителями ИИ и возможностями, которые соперничают даже с самыми передовыми ПК или высокопроизводительными графическими процессорами, — я считаю, что это достижимо.

"Просто покупай индекс", говорили они. "Это надежно". Здесь мы обсуждаем, почему это не всегда так, и как жить с вечно красным портфелем.

Поверить в рынокДействительно, интересно знать, что вы можете управлять компактной версией DeepSeek (наряду с многочисленными другими большими языковыми моделями) прямо на своем мобильном устройстве, без необходимости подключения к Интернету. Хотя скорость и точность могут не соответствовать скорости и точности облачной модели, протестированные мной устройства смогли быстро предоставить ответы, что делает их весьма практичными.

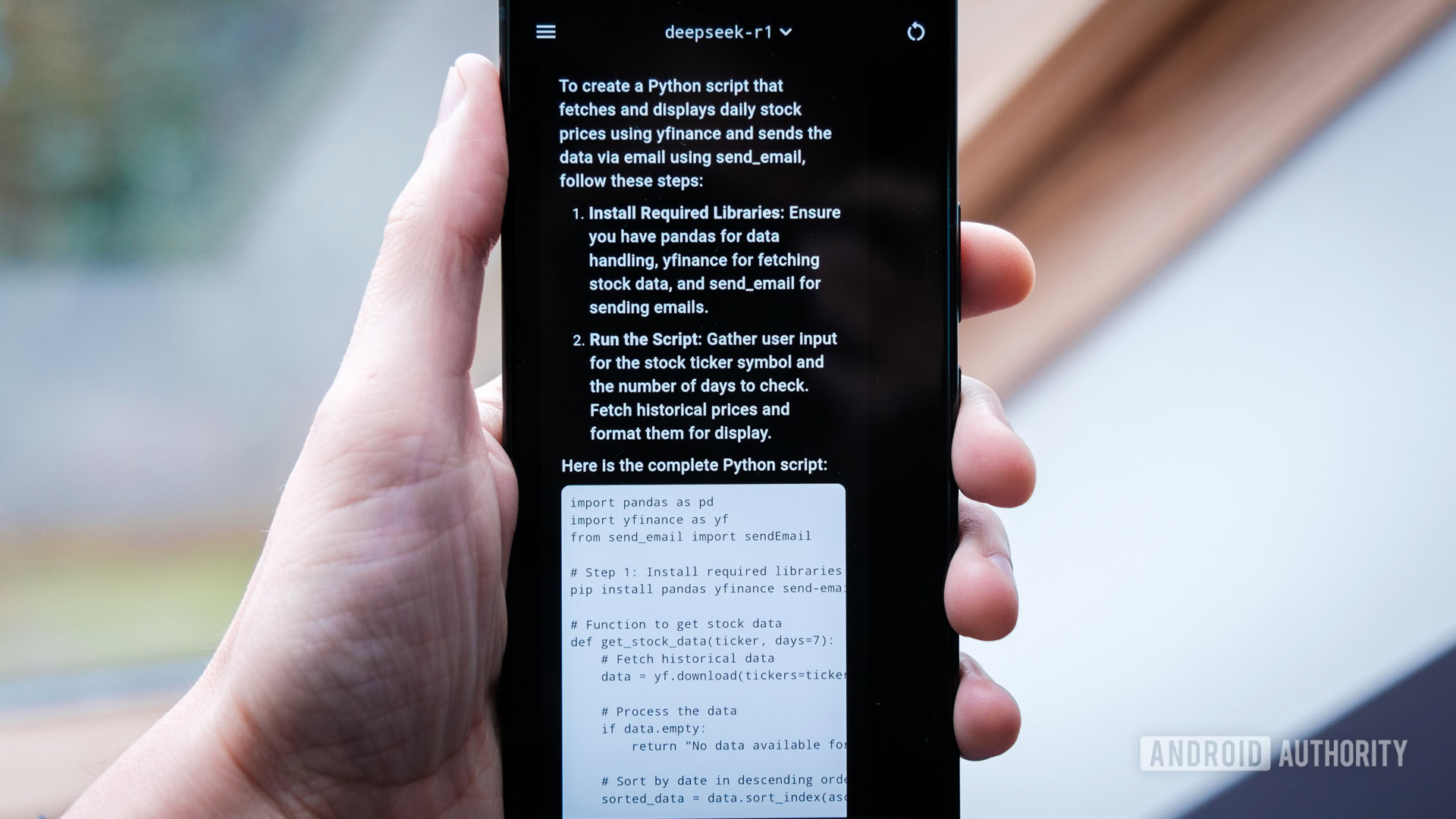

Более того, важно отметить, что эти меньшие модели все еще способны помогать в решении задач, прояснять сложные концепции и даже генерировать функциональный код, как это делает их более крупный аналог.

Я весьма поражен производительностью, учитывая, что он работает в устройстве, достаточно маленьком, чтобы носить его с собой. Хотя я бы не советовал всем спешить делать то же самое, тем, кто действительно увлечен развивающимся миром ИИ, может быть полезно поэкспериментировать с локальными моделями ИИ на своих собственных устройствах.

Как энтузиаст технологий, я обнаружил, что настройка офлайн LLM (Language Learning Model) на моем телефоне может быть довольно хлопотной, и процесс не такой гладкий, как с использованием Gemini от Google. Мой путь исследования и настройки также показал, что смартфоны — не самые удобные платформы для новичков, чтобы попробовать себя или создать новые инструменты ИИ. Если мы стремимся к созданию динамичного рынка, заполненного захватывающими приложениями ИИ, нам нужно сделать эти среды более доступными, чтобы пользователи могли освободиться от текущих ограничений OEM.

Локальные модели на удивление хорошо работают на Android, но их настройка — занятие не для слабонервных.

Интересно отметить, что проблема была не в производительности; вместо этого, передовые телефоны Snapdragon 8 Elite, которые я тестировал, справились с удивительно хорошей обработкой умеренно больших моделей из семи и восьми миллиардов параметров исключительно на своем ЦП, тактовая частота которых составляла 11 токенов в секунду, что быстрее, чем может прочитать большинство людей. Фактически, вы можете запустить модель Phi-4 из 14 миллиардов параметров, если у вас достаточно оперативной памяти, хотя вывод падает до все еще приемлемых 6 токенов в секунду. Однако запуск этих больших языковых моделей создает значительную нагрузку на современные процессоры смартфонов за пределами бенчмаркинга, в результате чего телефоны заметно нагреваются.

Примечательно, что устаревший Pixel 7 Pro умудряется запускать меньшие модели, такие как llama3.2 от Meta, с обработкой около пяти токенов в секунду. Однако попытка запустить более крупные модели, такие как DeepSeek, значительно нагружает возможности старых телефонов. К сожалению, я не смог найти никакого ускорения NPU или GPU для смартфонов с использованием протестированных мной методов, которое бы значительно улучшило производительность на старых устройствах. Поэтому запуск более крупных моделей невозможен, даже с самыми мощными процессорами Android.

Без доступа в Интернет или функций помощника мало кто сможет найти полезным местное образование LLM.

Несмотря на современные продвинутые смартфоны, я считаю, что большинство людей найдут приложения для запуска Large Language Model (LLM) на своих устройствах довольно ограниченными. Такие модели, как DeepSeek, Llama и Phi, являются фантастическими инструментами для проектов на ПК с большим экраном, но их может быть сложно эффективно использовать на небольшом смартфоне из-за таких ограничений, как отсутствие доступа к Интернету, невозможность взаимодействия с внешними функциями, такими как процедуры Google Assistant, и трудности с передачей документов для реферирования через командную строку. Вместо этого производители телефонов интегрируют инструменты ИИ в приложения, такие как Gallery, сосредотачиваясь на более конкретных вариантах использования, которые лучше подходят для взаимодействия большинства людей с различными типами моделей.

Хотя и волнительно, что некоторые продвинутые компактные модели изучения языка (LLM) могут работать на смартфонах, мы все еще далеки от экосистемы, где у потребителей есть широкий выбор помощников. К сожалению, смартфоны не являются основным фокусом, когда дело доходит до обучения или запуска последних моделей, не говоря уже об оптимизации для разнообразных возможностей аппаратного ускорения, доступных на платформе. Однако я надеюсь, что больше разработчиков будут вкладывать сюда время и ресурсы, поскольку здесь есть определенный потенциал.

Если вы заинтересованы в тестировании DeepSeek или нескольких других известных крупных языковых моделей на своем персональном смартфоне, я описал два метода, которые помогут вам начать.

Как установить DeepSeek на телефон (простой способ)

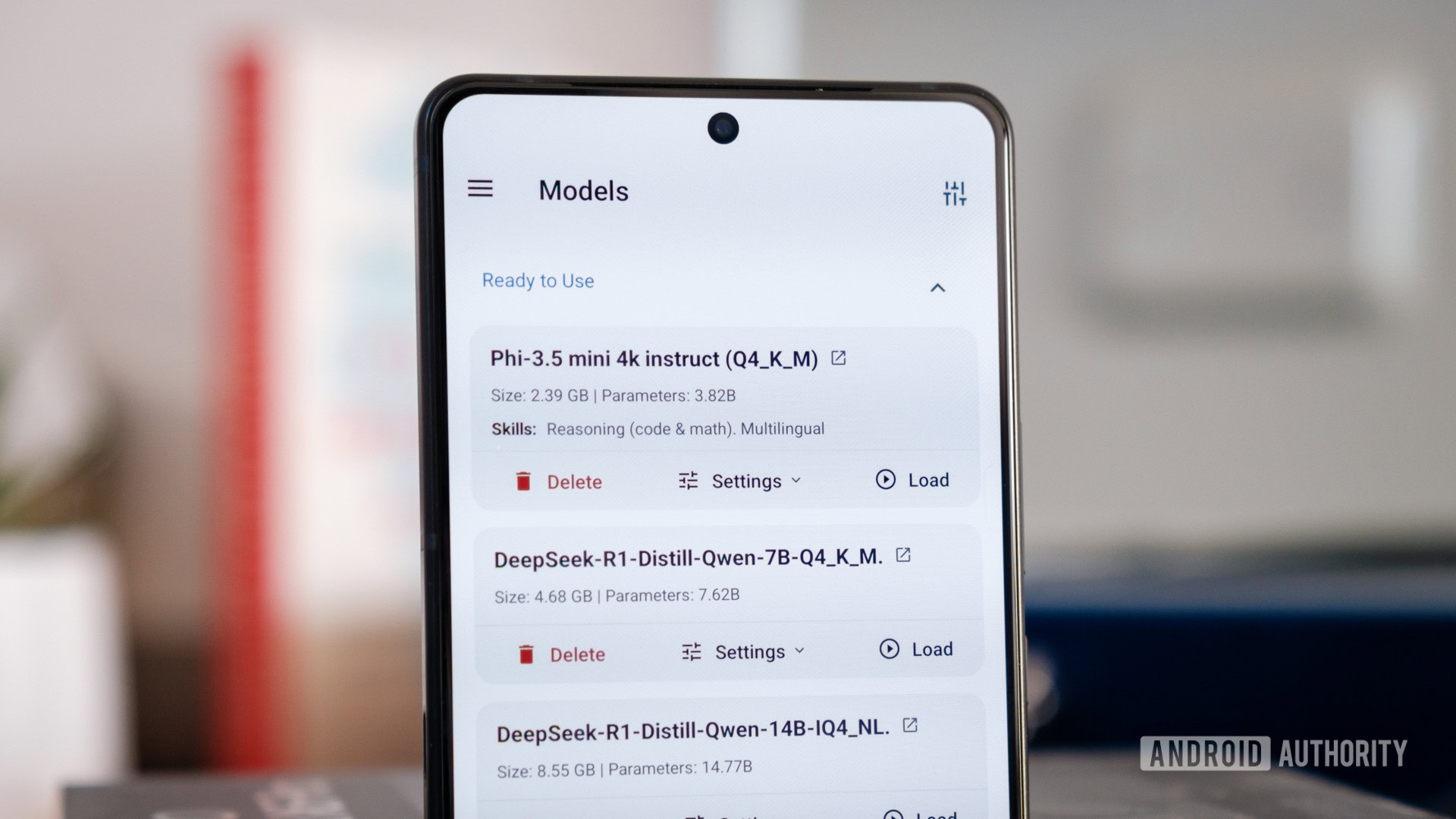

Для непринужденного общения с ИИ на вашем устройстве Android или iOS попробуйте PocketPal AI. Если вы пользователь iPhone, PrivateLLM тоже может вам подойти. Помните, что ваш телефон должен иметь хороший процессор и достаточно быстрой оперативной памяти для бесперебойной работы; 12 ГБ отлично подойдет для небольших, сжатых моделей 7b/8b, но 16 ГБ предпочтительнее, если вы планируете экспериментировать с более крупными моделями 14b.

С помощью приложения вы получаете доступ к многочисленным моделям, включая DeepSeek, LLama, Phi и многим другим, через широко используемую платформу HuggingFace. Однако широкий спектр опций в HuggingFace может быть подавляющим для новичков, поскольку возможности поиска в PocketPal AI довольно ограничены. Кроме того, пользовательский интерфейс компактен, что затрудняет определение официальной или лучшей модели для вашего устройства. Чтобы обойти эту проблему, вы можете вручную импортировать модели, которые вы скачали отдельно, что упрощает процесс.

Хотите запустить локальный ИИ на своем телефоне? PocketPal AI — это очень простой способ сделать это.

К сожалению, я столкнулся с несколькими проблемами при использовании PocketPal AI, такими как неудачные загрузки, неотзывчивые разговоры и полное падение приложения. По сути, лучше не выходить из приложения во время использования. Кроме того, некоторые ответы внезапно обрывались из-за небольшого размера окна по умолчанию, что оказалось проблематичным для болтливых программ, таких как DeepSeek. Хотя на первый взгляд это кажется простым, позже вам, возможно, придется углубиться в более сложные настройки. Наконец, я не смог удалить чаты в приложении.

Замечательно, что производительность высокая, и даже есть автоматическая функция освобождения оперативной памяти путем выгрузки модели, когда она простаивает. Запуск DeepSeek и подобных моделей в автономном режиме становится проще таким образом, хотя есть и другой метод.

…и трудный путь

Второй метод, который я рекомендую, использует Proot и Termux для установки Ollama, широко используемого инструмента для локальной работы с моделями LLM (похожего на PocketPal AI). Я обнаружил, что этот метод более надежен по сравнению с предыдущим приложением. Существует несколько способов установки Ollama на ваше устройство Android, но я собираюсь сосредоточиться на подходе Давиде Форнелли, который использует Proot для создания новой и съемной среды Debian для работы. Эта установка наиболее удобна для настройки и управления, особенно если вы планируете удалить Ollama после некоторых экспериментов. Хотя производительность Proot не совсем нативная, она достаточно удовлетворительна. Для полного понимания процесса я рекомендую ознакомиться с полным руководством; однако я привел основные шаги ниже:

1. Установите Termux и FUSE (файловая система в пространстве пользователя) на ваше устройство Android.

2. Запустите «su», чтобы получить доступ root, затем обновите систему с помощью «apt update» и «apt upgrade».

3. Установите Proot с помощью «apt install proot».

4. Создайте среду Debian chroot с помощью «proot-mkdebian».

5. Установите Ollama в этой среде с помощью «apt install ollama».

6. Настройте все необходимые переменные среды, и все готово!

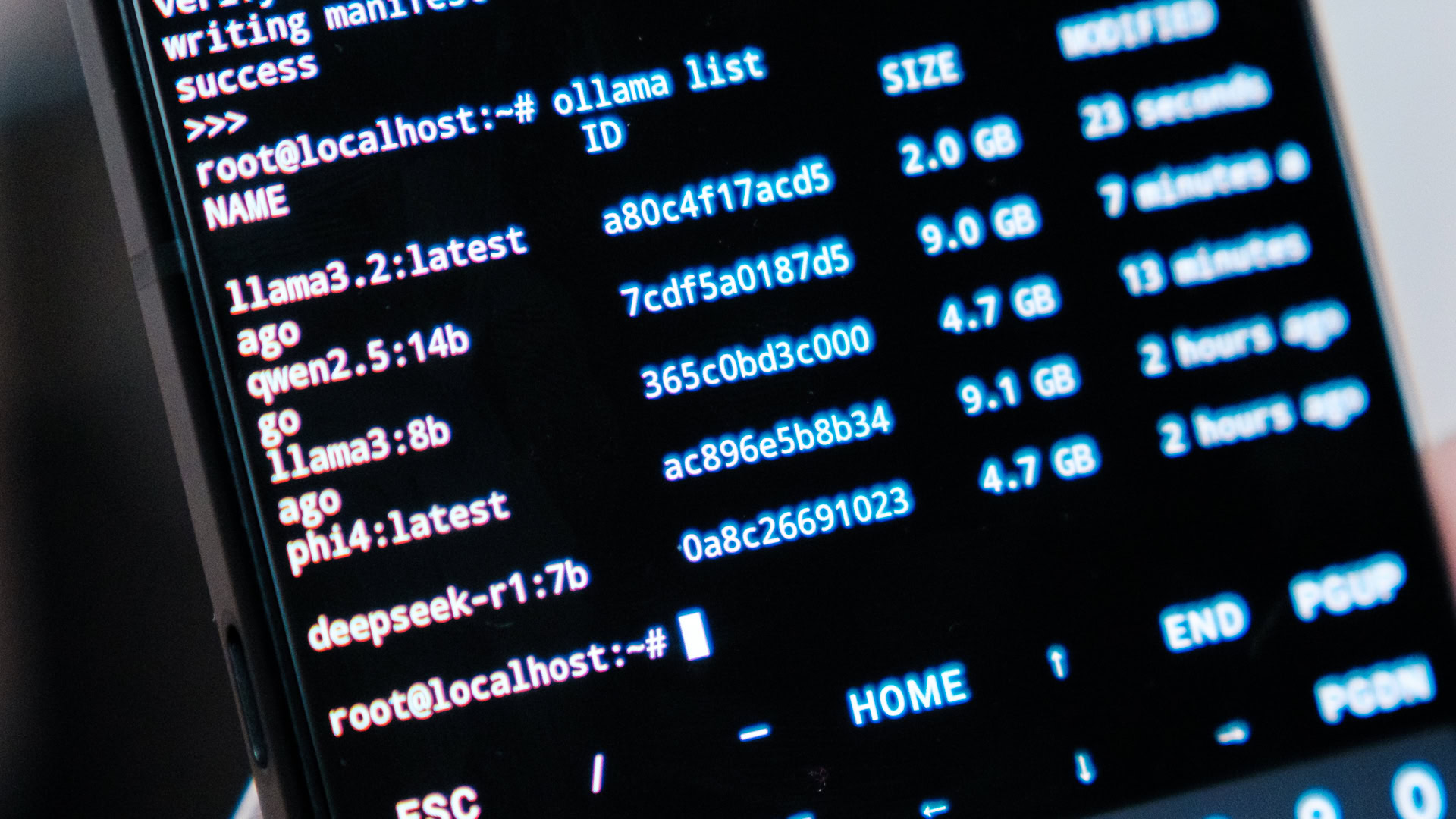

После установки Ollama войдите в среду Debian через Termux и выполните команду «ollama serve«, чтобы запустить сервер. Чтобы остановить сервер, просто нажмите CTRL+C, что освободит ресурсы вашего телефона. В ходе этого процесса вы можете изучить различные способы взаимодействия с Ollama и запустить некоторые существенные языковые модели.

В Termux у вас есть возможность открыть новое окно, войти в нашу среду Debian, а затем заняться командной строкой взаимодействия с Ollama. Этот метод предлагает самое быстрое и надежное взаимодействие с Ollama, особенно на устройствах с ограниченным объемом оперативной памяти, и в настоящее время это единственный подход к удалению моделей для освобождения места на диске.

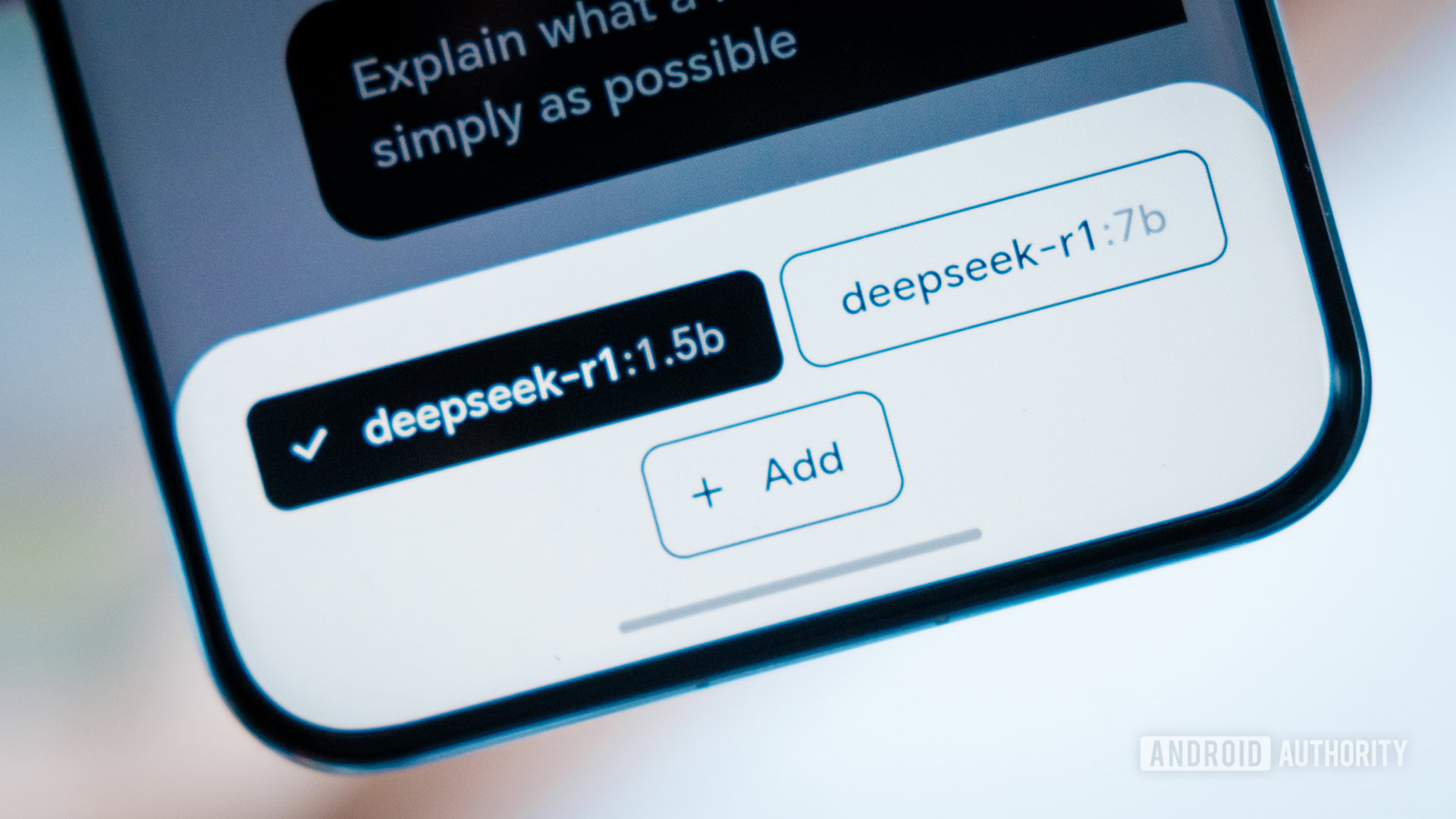

Чтобы начать диалог с DeepSeek-R1, просто введите команду: «ollama run deepseek-r1:7b«. После загрузки взаимодействуйте напрямую с командной строкой, и ваша модель предоставит ответы. Кроме того, не стесняйтесь выбирать любую другую модель подходящего размера из аккуратно организованной библиотеки Ollama.

Вместо этого вы можете выбрать приложение Ollama от JHubi1 на Android. Это приложение взаимодействует с Ollama и предлагает более приятный пользовательский интерфейс для общения и выбора моделей в соответствии с вашими предпочтениями. Однако следует отметить, что это дополнительное приложение может потреблять некоторое количество оперативной памяти, потенциально замедляя работу менее мощных смартфонов. Кроме того, ответы могут казаться немного медленнее по сравнению с взаимодействием через командную строку из-за дополнительных требований к коммуникации с Ollama. Тем не менее, если вы ищете долгосрочное использование локальной языковой модели (LLM), это может быть стоящим улучшением с точки зрения пользовательского опыта.

Какие программы LLM можно запустить на смартфоне?

Хотя мыслительный процесс DeepSeek увлекателен, я не уверен, что это лучшая большая языковая модель для повседневного использования, особенно при рассмотрении мобильных устройств. Даже его модель из семи миллиардов параметров может зависать во время продолжительных разговоров на 8 Elite, делая взаимодействие трудоемким из-за его длинной цепочки рассуждений. К счастью, существует множество альтернативных моделей, которые предлагают более высокую производительность без ущерба для качества. Например, Llama от Meta, Phi от Microsoft и Mistral эффективно работают на различных смартфонах. Чтобы получить наилучший опыт, выберите модель, которая соответствует оперативной памяти и вычислительной мощности вашего телефона.

В общем, для небольших моделей с 3 миллиардами параметров требуется около 2,5 ГБ свободной оперативной памяти, в то время как для более крупных с 7 и 8 миллиардами параметров требуется около 5-7 ГБ. Модели с 14 миллиардами параметров могут потреблять до 10 ГБ и так далее. Это требование к оперативной памяти примерно удваивается каждый раз, когда удваивается размер модели. Поскольку смартфоны совместно используют оперативную память со своими операционными системами, другими приложениями и графическими процессорами, важно иметь буфер как минимум в половину требуемой оперативной памяти модели (больше, если вы хотите бесперебойного использования). Например, телефоны с 12 ГБ быстрой оперативной памяти могут запускать модели с 7 и 8 миллиардами параметров, но для моделей с 14 миллиардами вам понадобится как минимум 16 ГБ или больше. Кроме того, имейте в виду, что Pixel 9 Pro от Google резервирует часть оперативной памяти для своей собственной модели Gemini.

Телефоны на базе Android могут выбирать из огромного количества небольших моделей с искусственным интеллектом.

Увеличение количества параметров в вашей модели значительно увеличивает вычислительную мощность, необходимую для ее обработки. Даже мощные чипы, такие как Snapdragon 8 Elite, немного с трудом справляются с Phi-4:14b от Microsoft и Qwen2.5:14b от Alibaba, но они все еще функциональны на высококлассном ASUS ROG Phone 9 Pro. Если вы стремитесь к результатам, которые можно считывать с нормальной скоростью с использованием текущего или последнего поколения оборудования, придерживайтесь моделей 8b или меньше. Для старых или средних телефонов выбор меньших моделей 3b приведет к значительной потере точности, но он все равно должен обеспечивать вывод, который не будет чрезмерно медленным.

Конечно!

Если вы предпочитаете запускать приложения ИИ на своем собственном устройстве, это совершенно нормально. Однако выбор облачных решений позволяет вам использовать более мощные модели, такие как ChatGPT, Gemini и полноразмерный DeepSeek через веб-браузеры или специальные приложения. С другой стороны, экспериментирование с ИИ на смартфоне было увлекательным занятием, и опытные разработчики могут раскрыть больший потенциал, используя API-перехватчики Ollama.

Смотрите также

- Разбор этой масштабной сцены с полным видом Рыцаря Семи Королевств.

- 10 лучших чехлов, которые обязательно нужно иметь для вашего нового Samsung Galaxy S25 Ultra!

- YouTube дает сбой — что делать, если в вашей ленте застрял NaN:NaN

- Лучшие телефоны Android для студентов 2024 года

- Лучшие телефоны для людей, чувствительных к ШИМ/мерцанию, 2024 г.

- Только что купили телевизор LG C5 OLED? Измените эти три ключевых настройки, чтобы получить наилучшее качество изображения.

- 10 Аниме, Которые Взбудоражат Вас! Список Обязательного Просмотра!

- 10 Самых Крутых Внутриигровых Гаджетов и Инструментов

- 10 недооцененных фильмов Сильвестра Сталлоне, которые стоит посмотреть

- Первые 13 вещей, которые нужно сделать с OnePlus 13

2025-02-01 19:19